无需绿幕,微软用AI为线上活动、AR/VR打造更自然虚拟舞台

或许虚拟舞台的虚拟活动将是我们迈向下一个时代的方式

(映维网 2020年06月04日)如果你看了今年微软的Build大会,你可能在“舞台”中发现其中一项创新技术。剧透警报:这个舞台是假的。主持人都呆在安全的家里。利用华盛顿大学的背景抠图过程和和Azure Kinect传感器,微软制作出仿如真实存在的大会演讲。

日前,微软人工智能负责人大卫·卡莫纳(David Carmona)撰文介绍了这次创新背后的故事,下面是映维网的具体整理:

我最喜欢的游戏是《帝国时代》。我是在大约20年前通过同事入坑,而我现在依然与我的儿子一起对战,但他总是毫不留情地把我干翻。从封建时代到城堡时代再到帝国时代,升级文明是游戏的一个神奇时刻。每一个时代都带来了新的技术,并为你抵御对手和赢得战争的战略开辟了全新的途径。

我有时候认为我们现在的世界同样是介于这样一个过时期。就如同《帝国时代》一样,新的时代将带来新的技术,并允许我们用来应对外部干扰和重新规划我们的战略。对于Covid-19新冠肺炎,我们发现自己正处身于一个饱受干扰的时刻,而这迫使着我们重新思考应该如何行事。现场活动就是其中之一。

疫情使得用户无法亲临大型现场活动,所以我们一直在寻找全新的方式来与客户沟通。再说一次,如果你参加了Build大会,你已经亲身体验了我们微软全球活动团队是如何将一切转移到虚拟空间。

我们采用了一种实验性的方法来展示我们的内容,并且通过利用其他人的创新,我们构建了一种在“虚拟舞台”中展示活动环节的独特方式。

这个概念来自于2017年Adobe Research和华盛顿大学发表的两篇背景抠图论文。这种方法允许任何人使用人工智能模型预测主体周围需要抠图的元素。它基本上取代了背景,不需要绿幕。

所以, 我们利用我们的Azure Kinect传感器和一个基于华盛顿大学研究的人工智能模型,以背景抠图过程作为基础,并为我们的演讲者创造一种可以轻松在家录制演示内容并出现在虚拟舞台的全新方法。

Azure Kinect摄像头通过红外线捕获深度信息,这种数据有助于提高人工智能模型的精度。我们使用一个名为Speaker Recorder的应用程序来管理来自Azure Kinect摄像头的两个视频信号:RGB信号和深度信号。录制完成后,我们通过命令行工具应用AI模型。具体的细节请查看微软人工智能实验室。

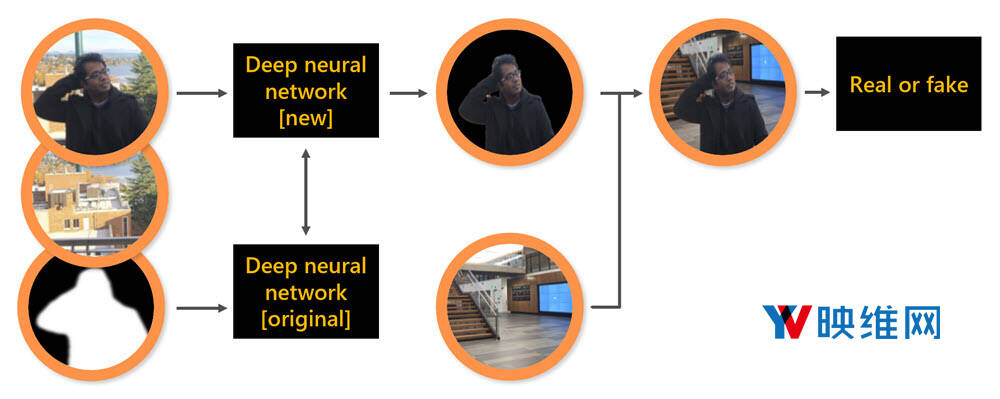

我们使用的人工智能模型是基于华盛顿大学最近发表的研究成果。这所大学开发的一种深度神经网络可以拍摄两幅图像,一幅包含背景,另一幅包含人员。神经网络的输出是一个平滑的透明掩模。

这个神经网络是基于图像训练,掩模工作则是手动完成。华盛顿大学的研究人员采用了Adobe提供的一个数据集,而其中的大部分图片都是设计者手工创建的透明掩模。

通过这种方法,神经网络可以学习如何平滑头发等区域。但它存在一定的局限性。如果此人穿着与背景颜色相似的服饰,系统会将其渲染为图像中的洞,从而破坏幻觉。

所以,华盛顿大学的研究人员将把这种方法和另一种方法结合起来。第二个神经网络尝试通过观察图像来猜测轮廓。在我们的虚拟舞台中,我们知道屏幕有一个人,所以神经网络将尝试识别那个人的轮廓。添加第二个神经网络可以消除颜色透明度问题,但头发或手指等小细节可能是一个问题。

有趣的是,华盛顿大学的研究人员创造了一种称为Context Switching(情景切换)的架构。根据情况,系统可以选择最佳解决方案,并从两个方案中获得最佳结果。

在我们的示例中,由于我们使用的是Azure Kinect,所以我们可以更进一步,用Kinect提供的轮廓替换第二个神经网络,因为存在捕获的深度信息,所以结果更加精确。

另一种称为对抗性网络的人工智能技术进一步改进了模型。我们将神经网络的输出与另一个识别图像真假的神经网络相连接。结果是一个可以创造更自然图像的神经网络。

人工智能模型、情景切换和神经网络创造了更为自然的舞台效果

结果?就是你在Build创新空间中看到的虚拟舞台。虚拟舞台的用途无穷无尽,这个过程允许我们灵活地将其应用到更长形式的会议之中,就像我们在微软人工智能虚拟峰会中的主题演讲一样。如果你想了解我们是如何为虚拟峰会利用舞台,请关于6月2日上午9点的Microsoft LinkedIn直播。

整个训练过程和代码请访问GitHub。谁知道呢,或许虚拟舞台的虚拟活动将是我们迈向下一个时代的方式。

我好像听到我的儿子正在叫我再来一盘《帝国时代》……