微软专利为AR/VR社交提出基于手势识别呈现emoji表情

基于手势呈现表情emoji

(映维网 2021年12月15日)emoji表情符号提供了一种在计算设备表达情感的机制。emoji可以采用静态或动画图形的形式,并通常以面部或其他传达情感的图像的形式出现。用户可以在电子邮件、聊天或短信等各种通信媒体使用emoji。

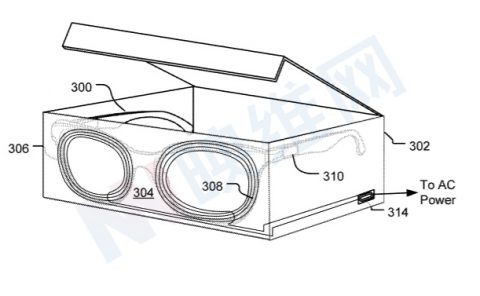

emoji同时可以在其他设置中共享,例如用户通过头戴式显示器设备参与的虚拟空间。在这样的虚拟空间中,用户可以使用手持控制器并通过由头显显示的用户界面交互共享表情。

然而,导航用户界面可能会分散用户对共享虚拟空间的注意力,并降低用户对共享虚拟空间的沉浸感。其他头显设备可能允许使用手势显示emoji,但由于可识别姿势的限制,系统可能只能识别有限的一组手势。

在名为“Hand gesture-based emojis”的专利申请中,微软介绍了一种基于铰接式手势追踪数据来识别手势,并作为响应,显示与所识别手势相对应的表情emoji的技术。专利同时介绍了与识别多个用户执行的手势和在用户之间共享表情有关的示例,以及与将eomji与对象相关联的示例。

铰接式手部追踪数据包括用户手的多个关节的位置和旋转数据,其允许准确检测可映射到多种emoji的各种手势。在另一方面,手势可以为用户提供一种自然直观的机制,从而在虚拟空间中与他人共享各种emoji并表达情感,而不涉及输入设备操作和用户界面导航。

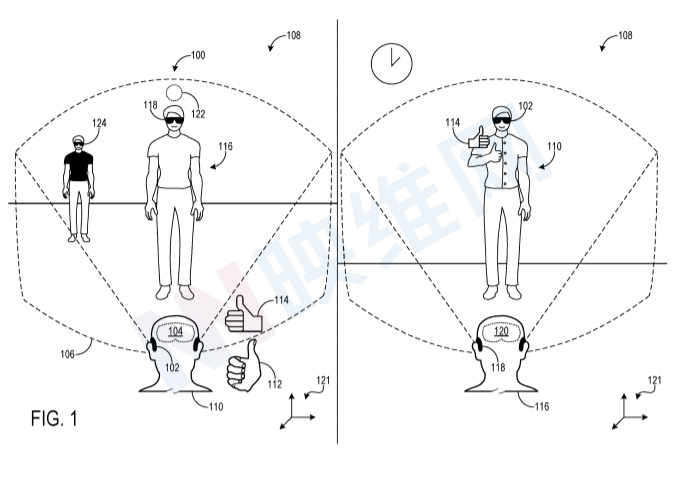

图1示出了通过集成显示器104呈现的共享虚拟空间100,并从两个不同的角度说明了虚拟空间,一个显示在图的左侧,另一个显示在右侧。首先参考左侧,显示器104呈现视场106内的虚拟图像,其作为头显设备102提供的混合现实体验的一部分。显示器104和混合现实体验可以采取任何合适的形式。

在所描绘的示例中,佩戴头显设备102的用户110用右手112执行竖起大拇指的手势。可以基于表示手部112的手部追踪数据,头显设备102识别竖起大拇指的手势并识别对应于该手势的emoji 114。在一个实施例中,头显设备102可包括传感器子系统(例如包括图像传感器),用于检测手势并形成表示检测到的手势的手部追踪数据。头显设备102然后经由显示器104呈现emoji 114,显示器104包括表示做出竖起大拇指手势的手的图形图标的显示。

占用物理环境108的另一用户116经由头显设备118参与共享虚拟空间100。除了在显示器104呈现emoji 114之外,头显设备102向头显设备118发送指令以呈现emoji,并且可以指定共享虚拟空间100中显示emoji的位置。可以使用任何合适的信道来发送指令,例如头显设备102和118之间的直接通信信道(例如蓝牙、WiFi、光学或声学信道),或者间接网络连接。响应于接收到指令,头显设备118在在指定位置呈现emoji 114。

表示由头显设备102和118追踪的手势的手部追踪数据可以参考为共享虚拟空间100和头显设备建立的共享坐标系。在图1中,所述共享坐标系由坐标轴121表示。可以使用任何合适的机制来建立共享坐标系。在一个示例中,用户以光学方式扫描放置在环境中的代码,从而在共享坐标系内的已知位置加入共享体验。

作为另一示例,物理环境中的一个或多个物理对象或位置可以预先指定为头显设备识别的空间锚,并且用户可以基于检测到的空间锚在共享坐标空间中的已知位置加入共享体验。作为另一个选项,用户可以通过在头显设备运行的应用程序导航到选定的服务器地址并在所述地址加入服务器,从而加入共享体验。在这样的示例中,用户可以在预选的初始位置加入体验。共享坐标系提供了一个共享参考框架,多个设备可以与之共享共同显示的虚拟内容,包括但不限于本文所述的emoji。

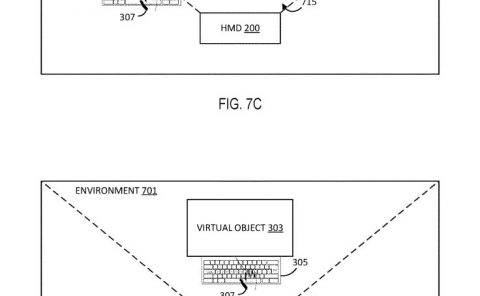

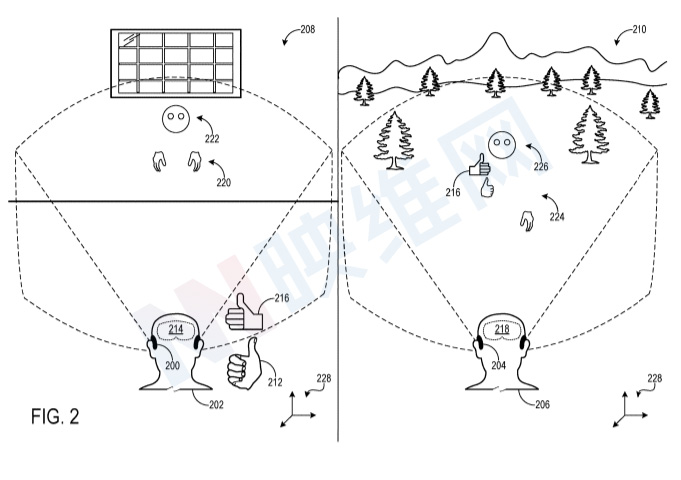

在图1的示例中,用户110和116处于公共物理环境中。在其他示例中,emoji可在共享相同共享虚拟空间但位于不同物理环境中的头显设备之间发送。图2描绘了其中用户202在第一物理环境208中佩戴的头显设备200与远程用户206在第二不同物理环境210中佩戴的头显设备204共享emoji的示例。

在所描绘的示例中,用户202用右手212执行竖起大拇指手势。头显设备200例如经由机载图像感测子系统识别所述手势。作为响应,与竖起大拇指手势相关联的emoji 216经由显示器214呈现。头显设备200进一步向远程头显设备204发送指令(例如,通过诸如因特网的网络),指示远程头显设备在共享虚拟空间中的指定位置呈现emoji。在接收到指令时,远程头显设备204经由显示器218呈现emoji 216。

在一个示例中,每个头显设备200和204同时可以呈现相应用户的表示。其中,头显设备200呈现远程用户206的手部表示220和远程用户的头部表示222。类似地,远程头显设备204呈现用户202的手部表示224和用户的头部表示226。在一个示例中,一个或多个表示可以基于传感器数据设置动画。例如,可以对手部表示220和/或224进行动画处理。类似地,头部表示222和226可以基于所表示用户的头部姿势和/或注视方向来设置动画。在一个示例中,头部表示222和226的眼睛可以设置动画以反映所表示用户的注视方向。例如,用户头部姿势可通过机载运动传感子系统确定。

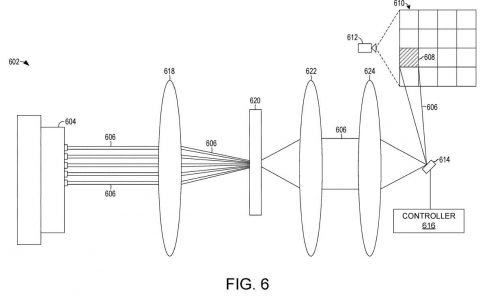

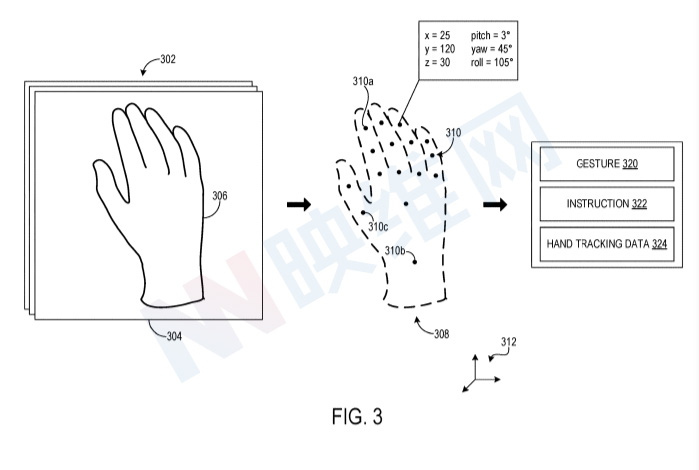

图3示出了示例管道300的示意图,可使用示例管道300形成铰接式手部追踪数据。在302,接收包括捕获人手306的帧304的图像帧序列。在一个示例中,头显设备可经由机载图像感测子系统捕获帧序列。在其他示例中,非机载图像传感子系统可获取帧序列,例如布置在物理环境内的固定位置中的图像传感器。图像传感子系统可包括任何合适类型的图像传感器,包括但不限于深度传感器、彩色图像传感器和立体图像传感器。

在帧304中捕获的图像数据,以及可能来自帧序列中的其他帧的图像数据,可用于生成铰接式手部追踪数据。图3示出了可与铰接式手部追踪数据相关联的示例手部模型308。手部模型308包括由点表示的多个关节310,其中一个或多个关节分别与坐标系中的三维位置和三维旋转相关联,坐标系由坐标轴312表示。

铰接式手部跟踪数据可以以任何合适的方式从帧304和可能的其他帧中导出。在一个示例中,可通过将帧304输入训练的机器学习分类器来确定关节位置和旋转。分类器配置为对每个关节的可能状态进行分类。在其他示例中,可使用几何拟合过程确定关节位置和旋转。几何拟合过程将检测到的手拟合到手部模型308,然后使用代价函数调整模型以将模型拟合到帧304。

关节310的位置和旋转共同代表手306的姿势。基于从帧304导出的手306的姿势,以及从其他帧导出的手的潜在其他姿势,可以识别手执行的手势。识别器可以使用几何方法,其中基于手部模型308的一个或多个关节310的位置和/或旋转来识别手势。在一个示例中,识别器可以评估一个或多个关节310之间的距离,可以考虑手模型308的一个或多个手指的卷曲,和/或可以在识别手势时考虑其他合适的几何因素。作为一个示例,可以基于识别拇指朝上,并且其他四个手指卷曲来识别竖起大拇指的手势。

在其他示例中,识别器可以利用经过训练的机器学习功能来基于铰接手数据的特征识别手势。任何合适的机器学习功能可用于检测手势,包括基于神经网络的识别器,例如生成性对抗网络和/或深度神经网络。在这样的示例中,机器学习功能可以为多个手势中的每一个输出图像数据帧(从中导出铰接的手数据)表示所述手势的概率。

在其他示例中,深度神经网络可用于将图像数据(例如从RGB图像帧导出)直接映射到手势,而无需首先确定关节手数据。在又一其它实例中,多层感知器可用于识别手势,例如通过在一系列帧上评估手关节并评估相对于头部关节或腕关节310b的关节位置。

手势识别的其他方法可以将手势与与手势相关的模板相匹配。例如,表示手势的模板可以通过计算手模型308的每个关节310相对于参考关节的位置和/或旋转来确定。对于给定的手姿势,可以确定表示手势的每个关节与模板的对应关节之间的距离。可以对不同的模板执行所述过程,以确定与手姿势最匹配的模板。然后可以识别与所识别的模板相对应的手势。在一个示例中,可以为一个常见手势确定多个模板。例如,多个模板可以表示常见手势的变化。

另外,在一个示例中,手势识别可以考虑手的速度。

在识别手势320之后,可以识别对应于手势的emoji并将其呈现在显示设备上。如上所述,在识别与手势320相对应的emoji时,可以从识别手势的显示设备向一个或多个其他显示设备发送指令322。指令322指示其他显示设备呈现emoji。

在一个示例中,指令可伴随图像数据(例如在emoji呈现期间显示的图形图标或动画)、音频数据(例如在emoji呈现期间播放)、指定在共享坐标空间中显示emoji的位置的位置数据、要与emoji和/或其他数据关联的目标(例如用户显示设备、手、物理对象、虚拟对象)的标识等等。

图3同时描绘了手部追踪数据324的输出。其中,手部追踪数据324可由显示设备与其他显示设备共享。例如参考图2,头显设备200可以与远程头显设备204共享手跟踪数据,使得远程头显设备能够基于用户202的手势呈现用户202的手部表示224。在一个示例中,共享的手部追踪数据324可包括所有铰接式手部追踪数据。在其他示例中,手部追踪数据可表示铰接式手部跟踪数据的简化版本。

在一些示例中,显示设备可以基于识别多个用户执行的手势来呈现emoji。图4A-4B显示了两个用户的击掌手势。在图4A中,佩戴头显设备402的用户400使用其右手404向远程用户发起击掌手势,远程用户通过头显设备呈现的头部表示406示出。远程用户的右手同时通过手部表示407来显示,其中手部表示可以基于远程用户的手势来动画化。

碰撞器408与用户400的右手404相关联,碰撞器410与远程用户的右手相关联。在此示例中,基于识别碰撞器408和410之间的交叉点,识别用户400和远程用户之间的击掌手势。交叉点检测可由任一或两个头显设备执行,并且头显设备可就手势的检测彼此通信。

名为“Hand gesture-based emojis”的微软专利申请最初在2020年5月提交,并在日前由美国专利商标局公布。