微软AR/VR专利研究将注视点追踪作为确定显示与隐藏HUD交互意图的机制

注视点追踪可作为确定显示与隐藏HUD交互意图的机制

(映维网Nweon 2022年06月28日)除了显示虚拟应用内容外,增强现实显示设备同时可以通过平视HUD用户界面显示状态指示器和/或其他信息。通过这个HUD显示的信息可以包括当前时间、剩余电量和通知等信息。

但当前的增强现实设备在显示这类用户界面元素时存在挑战。例如,透明增强现实显示设备显示HUD的一种方法是,当设备相对于真实世界背景视图移动时,将HUD显示为相对于设备的透明显示器(显示锁定)位置固定。然而,以显示锁定方式持续显示HUD可能会遮挡用户视场。另一方面,省略这类HUD的显示会带走可能对用户重要的可浏览信息。

作为一种解决方案,HUD可以保持隐藏状态,直到收到显示HUD的用户输入。对于这一点,设备需要首先确定用户的意图,亦即希望显示信息的意图。

在名为“Determining user intent based on attention values”的专利申请中,微软认为注视点追踪可作为确定显示与隐藏HUD交互意图的机制。这家公司认为,与语音或手势等其他输入机制相比,眼神注视提供了更多的隐私,并且在使用环境中干扰他人的可能性更小。

当然,从注视追踪信号中检测用户意图并不容易。人眼的自然运动是扫视式,即便在视觉上聚焦于特定的注视位置时,眼睛都会在注视位置之间自然地快速移动。所以,很难根据眼睛注视样本确定用户是否有意显示或隐藏HUD。

在发明中,微软指出根据空间意图模型检测到的用户注意来确定用户与动态HUD交互的意图。简而言之,显示设备可以利用眼动追踪传感器来采样用户的注视方向。将样本提供给空间意图模型,后者以适应眼跳运动的方式计算使用环境中一个或多个位置的时间相关注意值。当用户注视透明显示器的特定位置,并足以表明与用户界面交互的意图时,系统可以显示之前未显示的用户界面元素。

在另一个示例中,显示设备可以基于头部追踪数据追踪用户的头部姿势,并响应于头部追踪数据确定用户显示HUD的意图。一旦显示,则可以使用空间意图模型来确定用户与所显示的用户界面元素交互的意图。在一个示例中,可以基于用户意图信号的进展逐步HUD中的信息。

这家公司表示,与使用传统注视点追踪输入系统的系统相比,上述方法可以帮助避免HUD显示的误报触发,以及用户意图的误报失误。

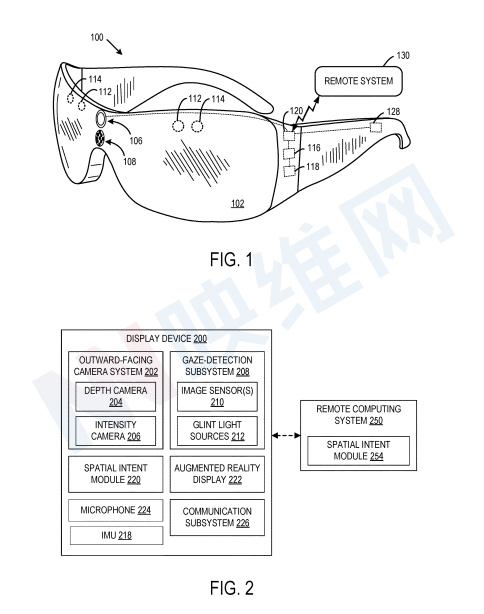

图2示出了示例显示设备200的框图。显示设备200包括空间意图模块220,其配置成帮助消除潜在的模糊注视信号。空间意图模块220可以采用存储在显示设备200的计算机存储器中的指令形式,并可由显示设备200的一个或多个逻辑设备执行。另外如254所示,空间意图模块220可在远程计算系统250实现。

如上所述,眼跳运动产生的模糊注视信号对准确确定用户的预期注视输入构成挑战。为了帮助消除预期注视输入与非预期注视输入之间的歧义,空间意图模块220可以基于来自眼动追踪系统的注视样本,确定使用环境中一个或多个注视位置中的每一个的时间相关注意值,并随时间更新注视位置的时间相关注意值。

例如,由空间意图模块220跟踪的注视位置可以表示真实世界环境中的物理位置、显示的虚拟对象的位置和/或显示器上的位置。

当特定注视位置的时间相关注意值满足所述注视位置的预定阈值条件时,可以触发与所述注视位置相关联的动作。例如,如果用户注视与用户界面的隐藏HUD相关联的位置,并且该位置的时间相关注意值超过预定阈值,则显示设备200显示HUD。

通过在接收到眼动追踪样本时更新与时间相关的注意值,空间意图模块220可以提供对作为用户注意力的预期焦点位置的洞察,即使在扫视眼球运动有时会将用户的视线转移到其他位置都是如此。

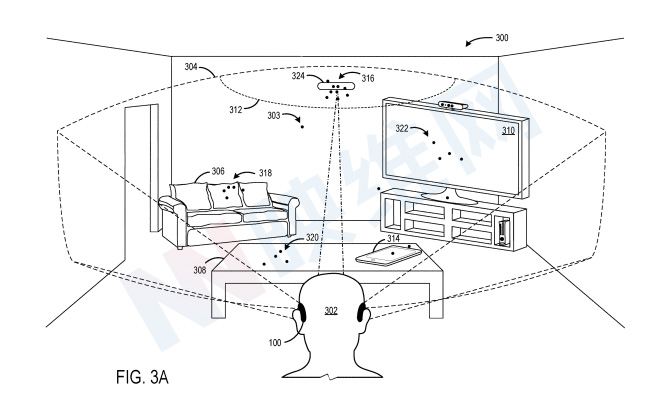

图3A示出了一个场景300。点表示根据眼动追踪系统获取的眼动追踪样本确定的眼动追踪位置,示例标记在303。眼动注视位置显示在视场304内的不同位置。显示设备100可以基于眼动注视样本确定用户302正在注视的一个或多个感兴趣位置。图3A中的感兴趣示例位置包括沙发306、表308、显示器310和平板电脑计算设备314等等。

眼动追踪传感器112检测用户眼睛的注视方向。显示设备100的控制器120可以将视场304内位置与注视方向进行比较,以确定注视方向是否与场景中的任何感兴趣位置相交。

在图3A中,用户302注视着位置312,如多个注视样本316所示。其他最近的注视样本(用点表示)表明,无论是出于意图还是扫视运动,用户的注视同时指向房间中的其他位置。例如,系统检测到朝向沙发306的多个注视样本318、朝向桌面308的多个注视样本320和朝向显示器310的多个注视样本322。

在一个实施例中,空间意图模型为视场中的一个或多个位置(包括位置312)中的每一个更新与时间相关的注意值。依赖于时间的注意值随时间变化,取决于检测到的位置注视样本数量,并通过衰减特性进行平衡。以这种方式,时间依赖性注意值对随时间变化的注意进行建模,与单个注视样本的瞬时位置相比,这可以更准确地确定意图,同时不涉及非自然的注视停留。

在图3A的示例中,计算设备100基于满足阈值条件的位置312的时间相关注意值来确定用户与用户界面元素324交互的意图。作为响应,用户界面元素324的默认外观可以改变(例如在颜色、大小、不透明度、形式等方面),从而指示用户意图的确定。

在其他示例中,用户界面元素324可以完全隐藏,直到确定用户意图,然后基于用户在位置312处的充分注视转换为视图。

用户界面元素324的外观变化为用户提供了在显示更多用户界面元素之前确认意图的机会。在一个实施例中,用户与用户界面元素324交互的意图可以通过用户继续主要注视位置312来进行确认(同时允许通过空间意图模型进行额外的眼球扫视运动)。

在其他示例中,用户可以使用手势(例如滑动、捏手势)、语音命令、头部手势(例如点头)、眨眼和/或任何其他合适的用户输入来确认其意图。在又一示例中,可以省略这样的确认。

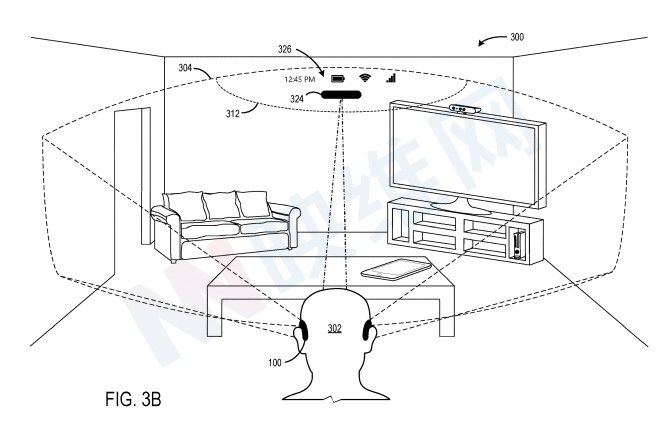

接下来参考图3B,在用户意图与用户界面元素324交互的这一附加表现形式上,显示隐藏的HUD 326。用户界面元素324在位置上已经改变到视场304内较低的位置,并且在外观上变得不太透明。另外,HUD 326显示当前时间以及表示剩余电量和无线网络信号强度的图标。通过利用注视触发HUD 326的显示,HUD 326不会阻挡用户的视线,除非用户查看HUD的可能意图得到充分体现。

空间意图模型可以通过诸如泄漏积分器之类的数学模型来确定代表用户对不同位置的注意力的时间相关注意值。在这样的示例中,具有与具有时间相关注意值的位置相交的方向的注视样本视为该位置的泄漏积分器的输入,并且泄漏积分器根据数学函数对输入进行积分。

另外,每个实体的注意值会随着时间的推移“泄漏”或衰减。因此,当用户注视某个位置时,该位置的时间相关注意值随时间而增加。同样,当用户将视线从该位置移开时,与时间相关的注意值会降低。

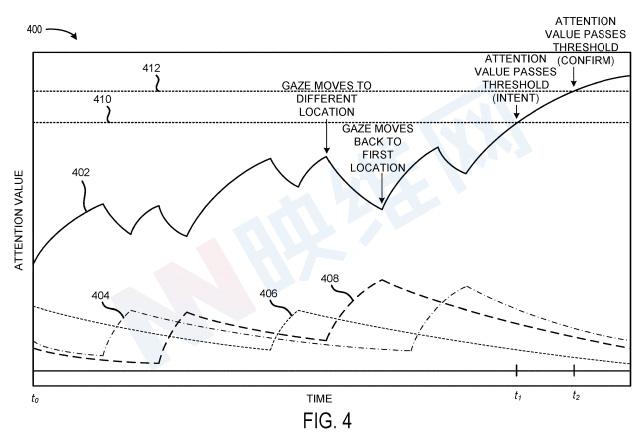

图4示出了与图3A中用户的注视位置相对应的示例时间相关注意值的图400。在所述示例中,依赖于时间的注意值通过一阶微分方程形式的泄漏积分器计算。例如,依赖于时间的注意值402建模用户对位置312的注意。

同样,与时间相关的注意力值404、406和408分别对沙发306、桌面308和显示器310的注意力进行建模。在时间t.sub.0,用户正注视着位置312,并且注意值402正在增加。随着注意力值的增加,增加的速度可能会减慢。稍后,用户看着不同的位置,注意值402开始减少(泄漏),而不同位置的注意值开始增加。当用户向后注视位置312时,注意值402再次增加。

如上所述,当位置的时间相关注意值满足阈值条件时,显示设备100的控制器120可以确定与该位置相关联的用户意图。

在图4中,在时间t.sub.1,位置312的时间相关注意值402超过第一阈值410,其指示用户意图与与位置312相关联的用户界面交互。在所述示例中,如上所述,在时间t.sub.1,控制器120显示用户界面元素324的外观从更透明的形式到不太透明的形式的变化。

在其他示例中,可以显示另一个合适的响应。在时间t.sub.2,位置312的时间相关注意值402超过第二阈值412,其指示对用户意图的确认。结果,控制器120显示附加的用户界面元素326。在其他示例中,可以使用单个阈值,并且图4的渐进意图识别/确认可以减少到相同的步骤。

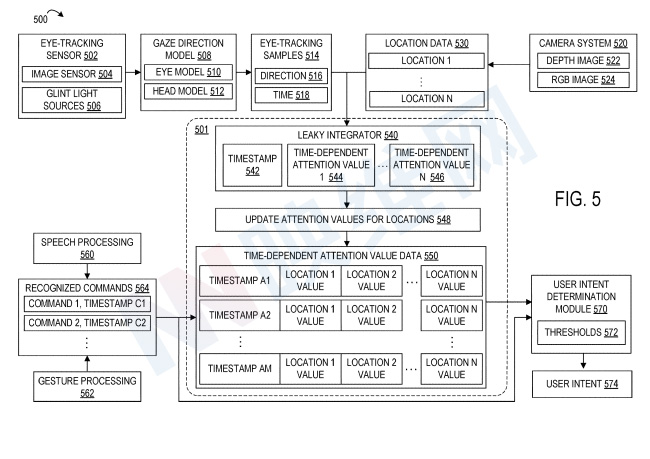

图5示示出了用于确定注视位置的时间相关注意值的系统500,其可以利用示例性空间意图模型501。处理管道可以在任何合适的计算系统实现。

系统500包括注视管道和一个或多个用户输入管道。在注视管道中,眼动追踪传感器502向注视方向模型508输出眼动追踪信号。眼动追踪传感器502包括图像传感器504和闪烁光源506。基于眼动追踪信号,注视方向模型508确定用户的注视方向。

注视方向模型508可以使用眼睛模型510和/或头部模型512来确定注视方向。利用所述信息,计算系统可以检测眼动追踪样本的注视方向是否与任何感兴趣位置相交。在视线确实与感兴趣的位置相交的地方,相应的眼动追踪样本514输入到泄漏积分器540中。

系统500同时包括与系统显示器视场内位置1-N相关的位置数据530。在所描绘的示例中,摄像头系统520经由深度摄像头522和/或RGB摄像头524对场景进行成像。可以处理包括深度图像和/或RGB图像的图像数据,以确定场景中的各种感兴趣位置,例如使用对象识别在场景中识别的实体。

另外,位置可以是系统显示器视场中的预定义区域,例如由软件开发人员为系统500提供的区域,和/或显示虚拟对象的位置(例如,图3A中的位置312和用户界面元素324)。

基于眼动追踪样本514和位置数据530的比较,泄漏积分器540将眼动追踪样本分配到相应的位置,并更新每个位置1-N(在544和546处指示)的时间相关注意值。更新后的每个位置的注意值可以存储为与最近的眼动追踪样本相对应的时间戳542。例如,如果眼动追踪样本在时间518的注视方向516对应于位置1,则泄漏积分器可在时间518确定位置1的正输入信号和其他位置的零输入信号。

在确定更新的注意值548之后,更新的注意值和相应的时间戳存储在时间相关注意值数据550的数据结构中(所述数据结构同时可以存储许多先前确定的时间相关注意值)。

在一个示例中,存储的时间相关注意值数据550可用于基于用户输入的时间戳将附加用户输入与时间相关注意值匹配。例如,到系统500的用户输入可以包括用户语音输入和/或用户手势输入。

因此,语音处理系统560可以从麦克风接收的语音输入输出识别的命令,而手势处理系统562可以输出识别的手势命令。

如上所述,可识别的命令564可包括意图确认命令。可将所记录的用于识别命令的时间戳与时间相关的注意值数据550进行比较,以链接基于眼睛注视确定的意图,从而确定用户是否已确认执行与位置相关联的动作的意图。

在一个示例中,可将识别命令的时间戳与时间相关注意值的时间戳542进行比较,以确定与命令关联的位置。

可将识别的命令564、注意值数据550和位置数据530输入到用户意图确定模块570中,用户意图确定模块570可应用一个或多个阈值条件572来确定用户意图574。用户意图确定模块570可以采用任何合适的形式。

在一个示例中,用户意图确定模块570可以简单地将依赖于时间的值与阈值进行比较。在其他示例中,用户意图确定模块570可以利用经过训练的机器学习功能,后者接收位置的时间相关注意值和识别的命令564作为输入,并输出用户打算与用户界面交互的概率。

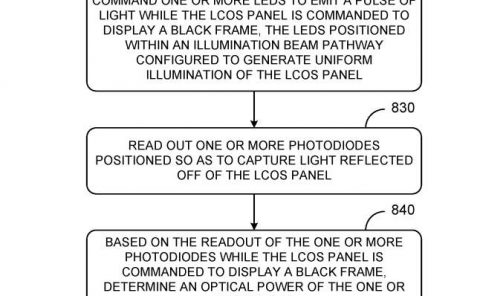

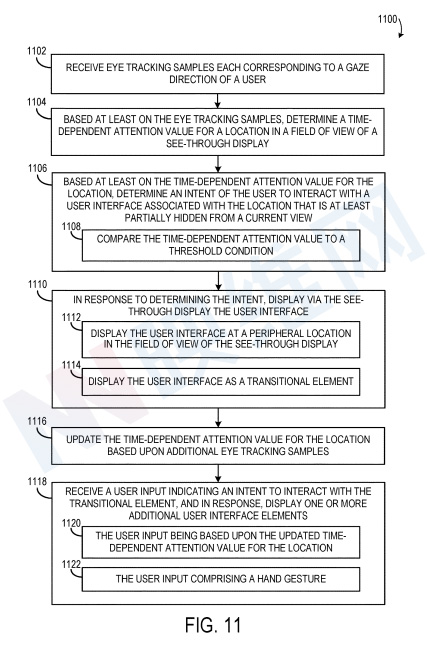

图11示出了使用空间意图模型基于眼动追踪来确定与用户界面交互的用户意图的示例方法1100。在1102,接收每个对应于用户注视方向的眼动追踪样本。在1104,基于眼动追踪样本,确定透明显示器视野中位置的时间相关注意值。如上所述,空间意图模型(例如,空间意图模型501)可用于确定场景中不同位置的时间相关注意值。例如,可以使用泄漏积分器来确定与时间相关的注意值。

在1106,基于位置的时间相关注意值,确定用户与与与当前视图中至少部分隐藏的位置相关联的用户界面交互的意图。在1108,通过将依赖于时间的注意值与阈值条件进行比较来进行确定。在一个示例中,在确定用户意图之前,用户界面可能保持隐藏状态。在其他示例中,默认情况下可显示初始的、不太显眼的用户界面元素,而它可逐渐转换以基于用户意图显示更多的用户界面。

在1010,响应于确定意图,包括经由透明显示器显示用户界面。在一个示例中,用户界面可以显示在视场中的外围位置,如1112所示。在1114,用户界面可以显示为过渡元素。过渡元素可以以任何合适的方式在外观上过渡,以指示用户意图的确定。

在1116,基于额外的眼动追踪样本更新该位置的时间相关注意值。在1118,接收指示与用户界面交互的进一步意图的用户输入,并作为响应,显示一个或多个附加用户界面元素。

一旦显示用户界面,可基于眼动追踪样本检测与用户界面的附加交互。因此在1210,可以基于眼动追踪样本,确定用户界面的时间相关注意值。在一个示例中,这可能包括确定用户界面的一个或多个用户界面元素中的每一个的时间相关注意值。

在1212,至少基于用户界面的时间相关注意值来确定用户与用户界面交互的意图。在各种示例中,用户与用户界面交互的意图可以可选地或附加地基于手势1214和/或语音输入1215。在1216,响应于确定意图,执行与用户界面相关联的动作。

相关专利:Microsoft Patent | Determining user intent based on attention values

名为“Determining user intent based on attention values”的微软专利申请最初在2020年12月提交,并在日前由美国专利商标局公布。需要注意的是,这只是一份专利申请,不确定微软是否会或将于何时进行商业化。