微软AR专利分享眼动追踪多路复用衍射元件,解决光源眼睛斜角定位问题

帮助解决眼动追踪摄像头和光源与眼睛成斜角定位的问题

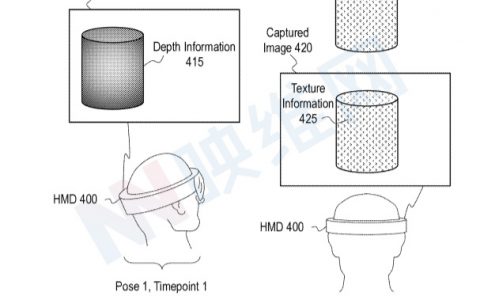

(映维网Nweon 2023年01月05日)眼动追踪越发成为头显的标准配置,各家厂商都在积极探索精确、轻型、紧凑和高成本效益的眼动追踪系统。对于AR头显,特定设计会将照明源和眼动追踪摄像头放置在视场外围,以避免妨碍用户查看真实世界背景。然而,这样的外围摄像头放置会产生用户眼睛的倾斜图像,并可能对检测特定注视方向造成问题。

另外,面部特征(例如睫毛和脸颊等)在从大斜角成像时会遮挡眼睛的视线。类似地,来自外围定位的照明源的光可能会被这样的面部特征遮挡。例如,倾斜放置的照明源可以照亮眉毛,而不是产生眼睛闪烁。

在名为“Multiplexed diffractive elements for eye tracking”的专利申请中,微软就介绍了用于眼动追踪的多路复用衍射元件,以帮助解决眼动追踪摄像头和光源与眼睛成斜角定位的问题。

在一个实施例中,复用衍射元件配置为将视窗不同视角的图像引导到摄像头。由于衍射元件阵列位于透明组合器以定位在用户眼睛前方,所以阵列可以避免倾斜定位的眼动追踪摄像头所遇到的潜在遮挡问题,因为当一个透视被遮挡时,另一个透视可以提供眼睛的未遮挡视图。

在其他示例中,复用衍射元件配置为将眼睛的图像引导到眼动追踪摄像头的图像传感器的多个不同位置,使得如果多个图像中的一个图像部分或完全移动离开图像传感器,则系统依然可以追踪眼睛。

另外,多路复用衍射元件可以从不同角度将来自照明源的光引向目镜。多路复用衍射元件配置为从照明源形成一个或多个虚拟光源,并将来自一个或更多个虚拟光源的光引向视窗。代替从位于斜角的主照明源照明眼睛,多路复用衍射元件可以用位于正面视角的虚拟光源照明眼睛,这可以帮助避免面部特征的遮挡。

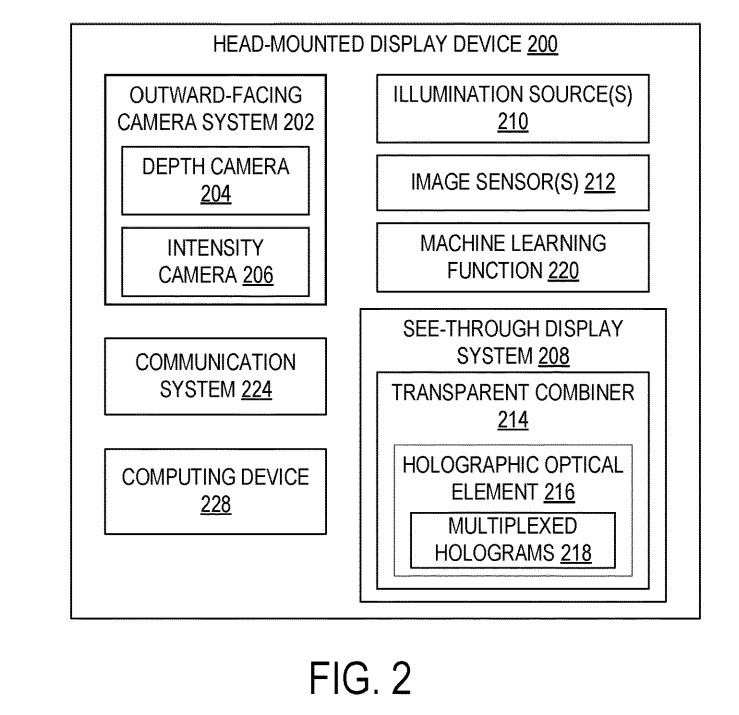

图2示出了包括眼动追踪系统的示例头显设备200框图。头显设备200包括透视显示系统208和眼动追踪系统,后者包括一个或多个照明源210、一个或更多个图像传感器212和透明组合器214,每个图像传感器212配置为捕获位于头显设备100的用户眼睛的图像。透明组合器包括全息光学元件(HOE)216。在其他示例中,HOE 216可以包括配置为重定向光的任何合适的平坦、标称透明衍射元件。

照明源210可以包括任何合适的光源,例如红外发光二极管(IR-LED)或激光器。在一个实施例中,每个照明源包括垂直腔表面发射激光器(VCSEL)。

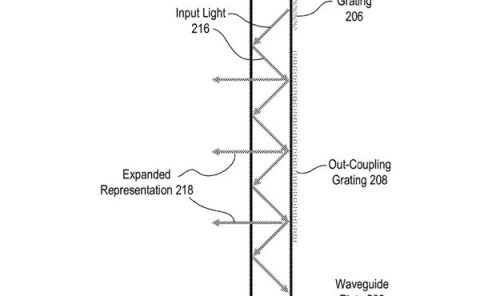

透明组合器214配置为在头显设备200的视窗与图像传感器212和/或照明源210之间提供光路。在各种实施例中,透明组合器214可以包括支撑HOE 216的波导、棱镜或透明基板。

HOE 216包括具有角度和波长选择性的多路复用全息图218。波长选择性可以提供衍射IR光同时对可见光相对不敏感的多路复用全息图,而角度灵敏度限制了由HOE衍射的入射光角度的范围。

在一个实施例中,多路复用全息图可以包括体三维折射率光栅,并且可以使用任何合适的材料形成。示例材料包括光敏自显影光聚合物膜、多色全息记录膜、全息记录聚合物和透明全息带。

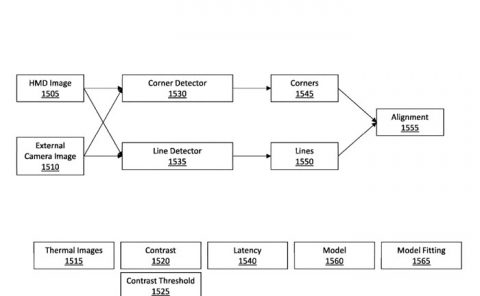

复用全息图218可以执行各种功能,和/或从照明源形成一个或多个虚拟光源以提供来自不同视角的闪烁光用于眼动追踪。在一个实施例中,可以将不同视角的图像引导到图像传感器的重叠区域。因此,眼动追踪系统可以包括可选的经过训练的机器学习功能220以处理图像数据。机器学习功能可以有助于处理从不同视角捕获眼盒的重叠图像的图像数据,或者甚至潜在的注视方向。

在一个实施例中,机器学习功能可以配置为即使在多个视角不重叠的情况下都能分析眼动追踪图像数据。机器学习功能220可以包括任何合适的算法,例如卷积神经网络(CNN)和/或深度神经网络(DNN)。机器学习功能220可以使用图像数据的训练集和相关联的ground truth眼睛位置数据来进行训练。

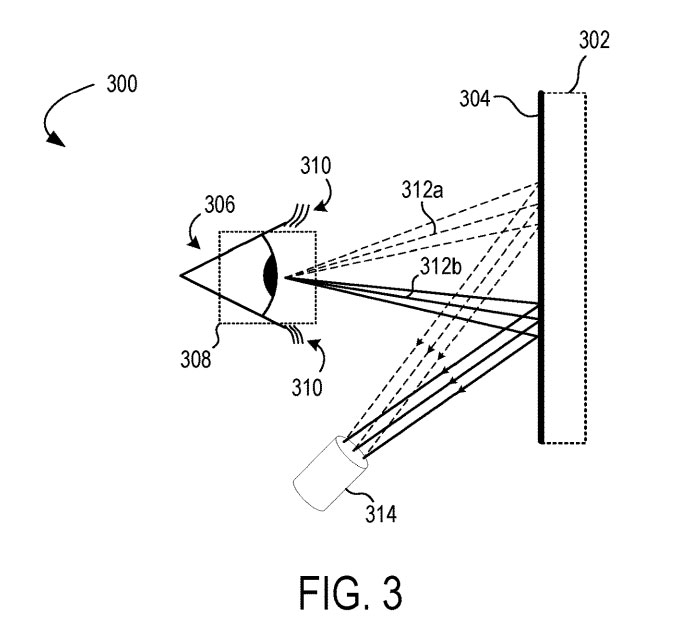

图3示出了包括包括HOE 304的透明组合器302的示例性眼动追踪系统300。如上所述,以大斜角放置的摄像头可能难以获取位于眼框308中的用户的眼睛306的适当图像以用于眼动追踪。

所以,HOE 304包括多路复用全息图,所述全息图配置为从两个不同的视角(一个由虚线光线312a)表示,另一个由实线射线312b表示)向摄像头314引导视窗308的图像。使用定位在透明组合器302的HOE 304允许从比使用倾斜定位的摄像头更直接的视角对眼睛进行成像。

另外,复用全息图的使用提供了位于视窗308中的眼睛306的不同视角,从而降低了图像遮挡的风险。HOE 304的复用全息图可以具有任何合适的波长和角度选择性。在一个示例中,HOE可以具有以照明源(图3中未示出)所使用的红外光的波长为中心的波长选择性,从而允许可见光在没有衍射的情况下通过。

同样,在一些示例中,多路复用全息图可以包括15°、10°或甚至5°或更小的角度选择性。在一个示例中,可以使用各自包括不同角度选择性的多个复用全息图。

图3所示的示例利用反射全息图。在其他示例中,可以使用透射全息图。

图4示出了包括具有波导402的透明组合器的示例性眼动追踪系统400。HOE 404包括经配置以将光耦合到波导402中的透射复用全息图,波导402经由全内反射将来自两个视角412a、412b的图像引向摄像头414。在一个示例中,多路复用全息图配置为准直从视窗408接收的图像光,以通过波导传播到摄像头透镜416以进行成像。

在包括波导组合器的其他示例中,当光被耦合到波导中时,复用的全息图可能不准直光。在这样的示例中,多路复用的全息图和波导配置为在波导内以相同数量的反弹来重定向不同的透视图像。在其他示例中,反射HOE可以与波导结合使用,以将光耦合到波导中用于眼动追踪。

在一个实施例中,头显可以使用相对小面积的图像传感器。在这样的设备中,当眼睛移动时,可能存在闪烁或瞳孔的图像移出图像传感器边缘的风险,从而影响眼动追踪性能。

所以在这样的头显中,包括多路复用全息图的透明组合器可以配置为将视窗的图像引导到图像传感器上的两个或多个不同位置。

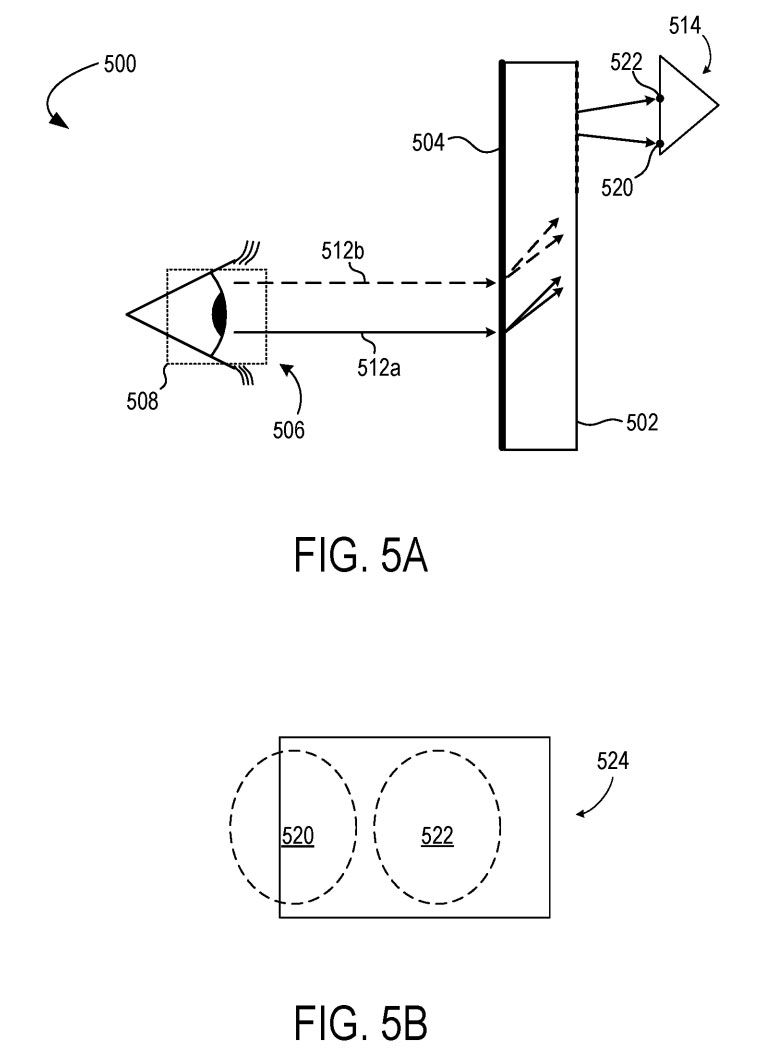

当一幅图像移动超过图像传感器的边缘时,另一幅图像可以完全移动到图像传感器,从而保持眼动追踪性能。图5A示出了这样的示例性眼动追踪系统500。

眼动追踪系统500包括具有波导502形式的透明组合器的透视显示器。透明组合器包括HOE 504,HOE 504包括多路复用全息图。这通过在波导502内将光线512a分成两条光线来指示,这两条光线在位置520和522处成像。

以这种方式,在图像传感器的两个位置处成像相同的透视图,或者根据在HOE 504中编码的多路复用全息图的数量可能更多。

图5B示出了图像传感器524的示意图,并且示出了与在图5A的位置520和位置522处成像的射线512a相对应的图像。这里,位置520的图像部分偏离图像传感器的边缘。然而,位置522处的图像完全位于图像传感器之上。

因此,通过将图像投影到图像传感器的不同位置,眼动追踪系统500可以避免一个图像部分或完全移动超过图像传感器的边缘的问题。

在一个实施例中,诸如HOE 504的HOE可用于在图像传感器的移位位置创建眼睛的散焦或失真副本。尽管这可能会破坏图像,但由于图像中的冗余,使用散焦或失真的图像可以令摄像头514(和眼动追踪软件)提取关于眼睛的更多信息。

作为一个示例,眼睛图像的两个副本可以在图像传感器的移位位置处成像,但每个副本具有不同的焦距。这可能会增加设备的“聚焦深度”,并可能改善整体眼动追踪。

包括多路复用全息图的全息元件可用于形成虚拟光源并从不同的角度照亮视窗。这可以允许使用较少数量的物理光源在角膜上形成较多数量的闪烁,并且可以允许用于选定闪烁位置的光从多个不同方向朝向眼睛。

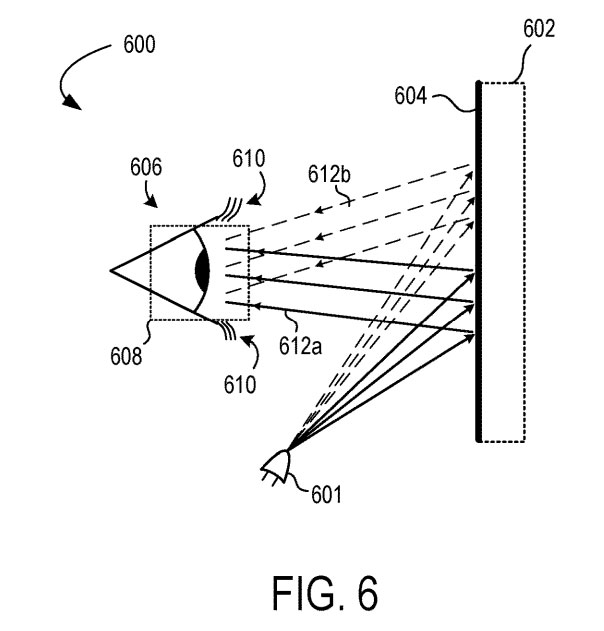

图6示出了包括照明源601和具有HOE 604的透明组合器602的示例性眼动追踪系统600。HOE 604包括两个多路复用全息图,其配置为经由从照明源601接收的光将两个虚拟光源(由光线612a、612b表示)引向用户的眼睛606。

在其他示例中,可以使用任何合适的多个复用全息图。这样,虚拟光源的数量可以大于或等于物理光源的数量。如图6所示,由多路复用全息图形成的虚拟光源可以从眼睛606上的不同视角将光引导到闪烁位置,这可以帮助避免睫毛610和/或其他面部特征的遮挡。

在其他示例中,包括复用衍射元件的任何其他合适的衍射元件阵列可以用于将虚拟光源引向眼睛。

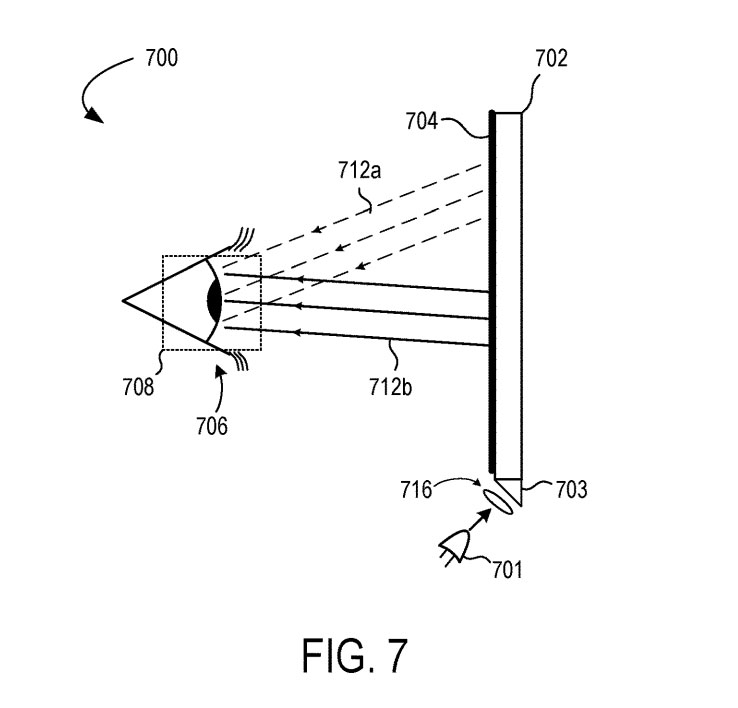

图7示出了配置为经由透明组合器的HOE形成虚拟光源的另一示例眼动追踪系统700。眼动追踪系统700包括照明源701、可选透镜716和具有波导702的透明组合器。来自照明源701的光在输入耦合元件703处进入波导,在HOE 704处被输出耦合,并引向目镜708。

在所述示例中,HOE 704包括两个透射复用全息图,其配置为形成虚拟光源(由光线712a、712b表示)。虚拟光源在从不同角度形成闪烁。在其他示例中,可以使用任何其他合适的多个复用全息图来形成任何其他合适数量的虚拟光源。

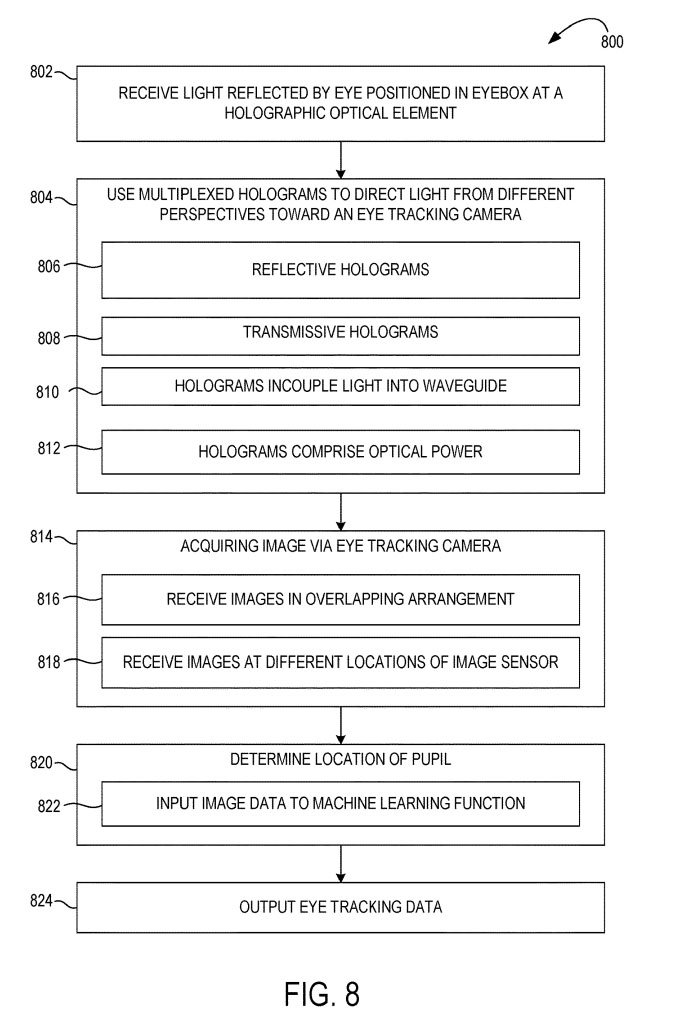

图8示出了用于通过在透明组合器上使用包括多路复用全息图的HOE来对眼动追踪系统中的视窗的不同视角进行成像的示例方法800。

802,在全息光学元件处从位于视窗中的眼睛接收反射的闪烁光。全息光学元件包括多个复用全息图,每个复用全息图接收来自眼睛不同视角的光。

804,使用复用的全息图将光引导到眼动追踪摄像头。

806,使用反射全息图衍射光。

808,使用透射全息图衍射光。

810,全息图配置为将光耦合到波导中,其中波导将图像传输到眼动追踪摄像头,而在其他示例中,与波导相反,使用自由空间布置。

814,通过在眼动追踪摄像头处从多路复用全息图接收的光获取眼动追踪图像。

816,以重叠布置接收眼盒的不同视角的图像。

818,在眼动追踪摄像头的图像传感器上的不同位置处接收图像。

820,确定眼睛瞳孔的位置。

822,将图像数据输入到训练的机器学习函数中以确定瞳孔的位置。

824,输出眼动追踪数据。例如,眼动追踪数据可以用于确定用户的注视方向,然后可以将其输出到利用注视数据的各种计算机应用和/或服务。

相关专利:Microsoft Patent | Multiplexed diffractive elements for eye tracking

名为“Multiplexed diffractive elements for eye tracking”的微软专利申请最初在2021年6月提交,并在日前由美国专利商标局公布。