微软专利探索提升HoloLens 2协作远程用户的沉浸式体验

支持远程混合现实设备用户结合3D表面重建(SR)网格数据和实时视频数据来查看本地MR设备环境

(映维网Nweon 2023年09月12日)诸如微软HoloLens 2这样的混合现实可以为远程用户提供沉浸式第一视角,并通过语音和图像叠加等方式来提供协作支持。这种系统可用于医疗,教学和维修维护等场景。随着技术的发展,有必要进一步提高远程用户的沉浸感,营造一种允许远程用户仿佛置身于本地环境中的氛围,从而进一步提高协作体验。

在名为”Mixed reality environment display using surface reconstruction mesh and live video overlay“的专利申请中,微软介绍了一种用于支持远程混合现实设备用户结合3D表面重建(SR)网格数据和实时视频数据来查看本地MR设备环境的方法。远程用户同时能够向本地MR设备的用户提供反馈,包括基于音频的反馈。

在一个实施例中,可以结合使用SR网格数据和摄影测量技术来生成与本地环境密切匹配的3D空间,然后将本地环境的实时视频馈电叠加在生成的3D空间。这种混合虚拟现实体验可以允许远程用户完全沉浸在相同的环境之中。

另外,实时视频馈送提供3D数据,使得实时视频馈送能够紧密贴合虚拟环境的3D SR网格,而不仅仅是显示二维视频。

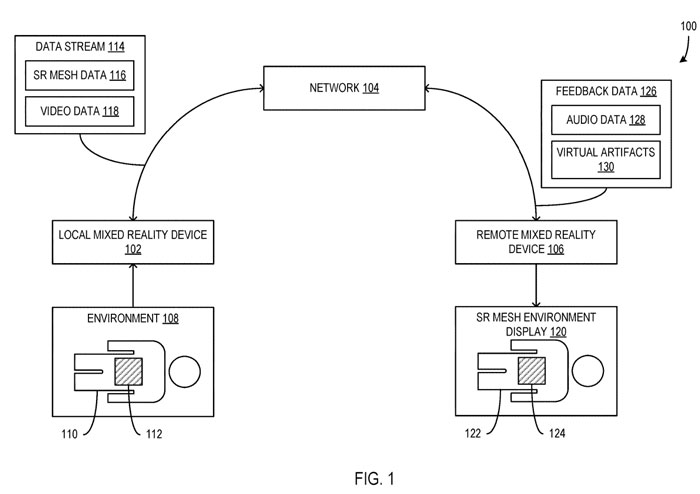

图1示出了配置为向远程设备106提供实时视频数据流118,以支持远程位置的用户能够查看环境108的系统100。其中,本地MR设备102捕获环境108的光学数据,并通过网络104将所获得的数据流式传输给远程MR设备106,远程MR设备106使用所述流式数据向远程用户显示表面重建(SR)网格环境显示120。

MR设备102包括摄像头或其他光学捕获接口或设备,并用于捕获代表用户正在查看的环境108中的区域的光学数据。MR设备102进一步包括深度传感器,从而捕获与光学数据相关联的景深信息。在这样的示例中,MR设备102使用景深信息来识别表面的相对位置并生成SR网格数据。

远程MR设备106包括以与上述本地MR设备102相同的方式配置的硬件、固件和/或软件。MR设备106包括用于检测位置、方向和/或移动的组件,例如一个或多个加速度计。

在一个实施例中,环境108包括多个不同的表面。例如,环境108可以包括手术室。

可以通过本地MR设备102捕获环境108中表面的位置,捕获与环境108相关的光学数据包括捕获表面的位置、表面的位置、表面的纹理、表面的颜色、表面的摄影测量数据等。

患者110和窗口区域112位于环境108中,并且患者110在整个手术或过程中趋向于保持静止。当患者110在环境108中就位时,与患者110的表面相关联的光学数据由本地MR设备102和/或其他光学捕获组件捕获。

环境中的窗口区域112定义为捕获实时视频数据118并将其提供给远程MR设备106的区域。窗口区域112可以是相对于患者110区域定义的静态区域。或者,窗口区域112可以是动态的,并且区域112位置可以由本地MR设备102的用户、远程MR设备106的用户和/或另一方或实体来调整。

窗口区域112包括多个光学捕获组件的视场,从而允许远程MR设备106的用户查看患者110的区域。在这样的示例中,多个光学捕获组件的捕获视场可以组合,使得远程MR设备106的用户在查看虚拟SR网格环境显示时可以在视场之间基本无缝切换。

例如,如果窗口区域112包括悬挂在患者110上方的两个静态摄像头的视场,这时可以根据他们正在查看患者的具体位置,向远程MR设备106的用户提供两个静态摄像头之一的实时视频馈送。

当用户转动其头部或以其他方式调整其视场以查看患者的其他位置时,可以提供另一个摄像头的实时视频馈送。

可选地,环境108包括一个或多个摄像头,并可由远程MR设备106的用户控制,使得用户能够改变摄像头的视场,从而在其实时视频馈送中看到所需的患者部分。

数据流114由本地MR设备102通过网络104提供给远程MR设备106。数据流114包括SR网格数据116和视频数据118。

SR网格数据116包括环境108的光学数据,以及基于所述光学数据指示环境中表面位置的数据。在一个实施例中,可以利用摄影测量技术从光学数据中提取环境的三维表面数据并生成SR网格数据116。

SR网格数据116包括表示环境三维空间中点的网格的数据,其中点和点之间的连接表示环境中表面的位置。另外,所述点在三维空间中的位置是根据捕获的光学数据确定。

在一个实施例中,SR网格数据116是基于由本地MR设备102或其他光学捕获组件从环境捕获的光学数据生成。另外,SR网格数据116包括叠加在SR网格的图像数据。在这样的例子中,从环境中捕获的光学数据转换成图像,并排列在SR网格的位置,使得SR网格以一定程度的精度提供环境中每个表面的摄影外观。

SR网格数据116由远程MR设备106用于向设备106的用户显示SR网格环境显示120。所显示的SR网格环境显示器120是具有多个定位表面的3D虚拟环境,从而使得虚拟环境看起来与本地MR设备102的环境108基本相同。

在初始时间间隔内捕获用于生成SR网格数据116的光学数据,生成SR网格数据116并提供给远程MR设备106。SR网格数据116生成后,开始捕获视频直播馈送的视频数据118并提供给远程MR设备106。

在这样的例子中,SR网格数据116保持静态。或者,在使用实时视频馈送期间偶尔更新SR网格数据116以反映环境108中的任何实质性变化。

数据流114的视频数据118包括与本文所述的窗口区域112相关联的实时视频馈送或流的视频数据。视频数据118由本地MR设备102的光学捕获组件捕获和/或视频数据118包括本地MR设备102用户视场的视频数据。

另外,对于视频数据118和/或数据流114包括3D位置数据和/或其他3D元数据,其可由远程MR设备106用于向设备106的用户提供相对于SR网格环境显示120的适当视场。

所述位置数据和其他元数据用于将视频数据118与SR网格数据116同步,从而在与所述环境108中的区域窗口112的位置相匹配的环境显示器120的位置向设备106用户显示所述实时视频馈送。

因此,设备106显示环境显示120,并将实时视频馈送的视频数据118叠加在环境显示器120的窗口区域124。所以,实时视频馈送参照环境显示120的表面发生。例如,在环境显示器120的窗口区域124中的患者网格122的虚拟表示之上,可以显示发生在患者110腹部的手术的实时视频馈送。

另外,反馈数据126通过网络104从远程MR设备106提供给本地MR设备102。反馈数据126包括音频数据128或其他相关数据。音频数据128包括远程MR设备106的用户的口头陈述,以播放给本地MR设备102的用户。

同时,本地MR设备102允许用户将音频数据从设备102发送到远程MR设备106,以便向设备106的用户播放。这样,设备102和106的用户能够相互交谈。

除了SR网格数据和视频数据外,其他类型的可视数据可以发送到远程设备106和/或显示给本地MR设备102的用户。

例如,对患者身体部分的其他医学扫描显示为叠加在患者的SR网格表示之上,比如说患者手臂的x射线扫描显示骨折。通过叠加在患者手臂的SR网格表示上,这样就可以很容易地在SR网格表示定位骨折的位置。

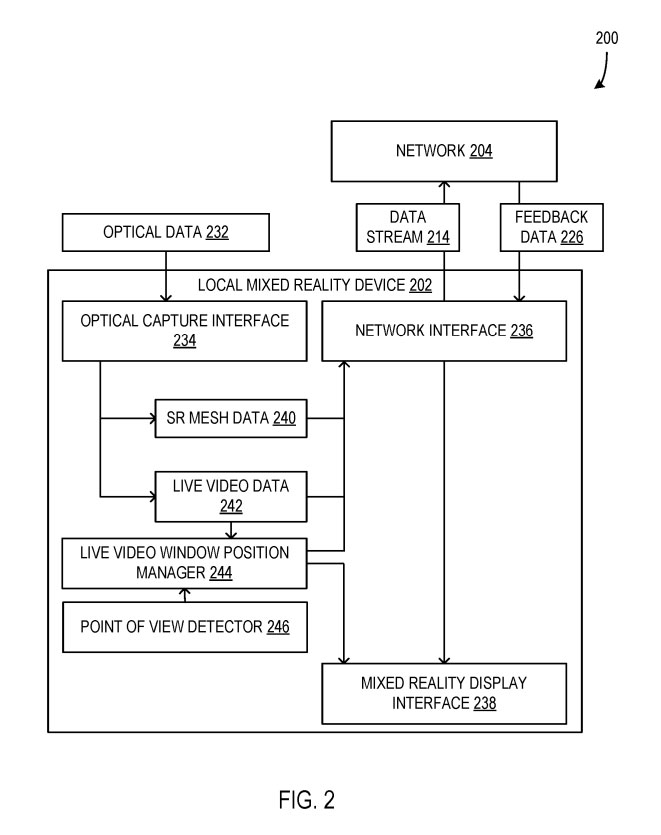

图2示出包括本地MR设备202的系统200的框图。

光学捕获接口234包括用于捕获环境的光学数据的硬件、固件和/或软件。光学数据232包括用于生成SR网格的SR网格数据240。

实时视频窗口位置管理器244配置为存储和维护环境中的实时视频窗口的位置、边界和/或其他特征。

现场视频窗口位置管理器244过滤来自现场视频数据242的光学数据,以确保通过网络204发送到远程MR设备的实时视频数据242在其视角看来具有意义。

视点检测器246配置为检测设备202和相关光学捕获接口234的当前位置和/或方向,特别是相对于诸如图1的环境108的环境。

本地MR设备202通过网络接口236接收来自网络204的反馈数据226。

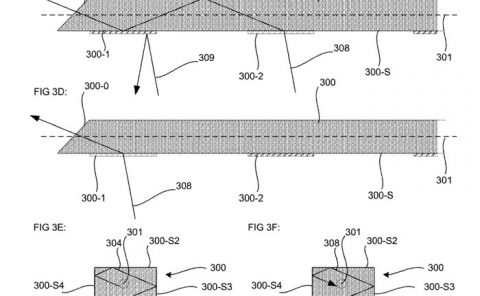

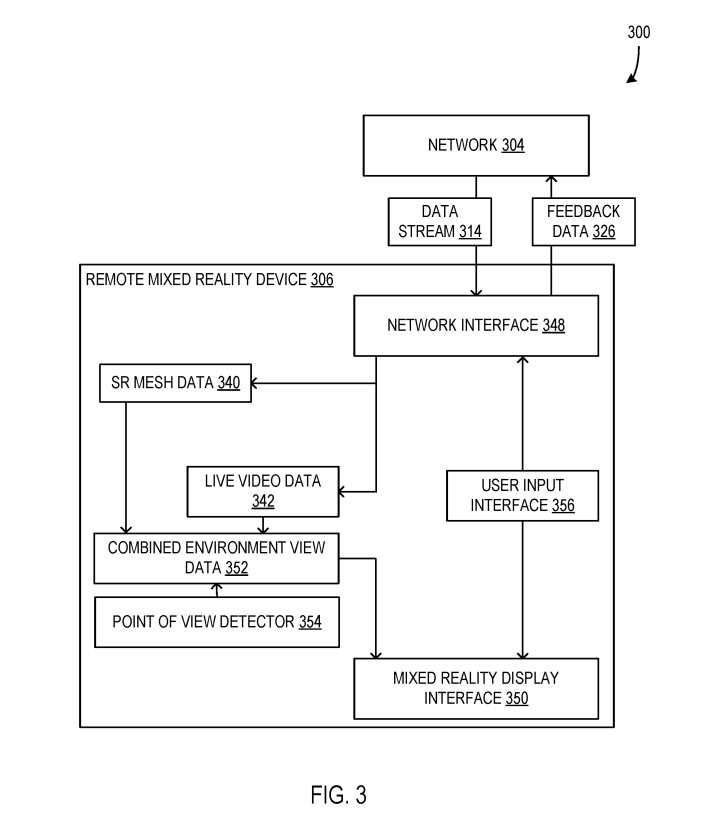

图3示出远程MR设备306的系统300。

在一个实施例中,数据流314包括从本地MR设备提供的SR网格数据340和/或实时视频数据344。例如,在过程的初始阶段提供SR网格数据340,然后在接收SR网格数据340之后提供实时视频数据342,并使远程MR设备306能够生成虚拟SR网格环境。

另外,将SR网格数据340和实时视频数据342组合成组合环境视图数据352,然后通过MR显示接口350将其显示给设备306的用户。

视点检测器354相当于图2中的视点检测器246,其配置为检测远程MR设备306的位置和方向,包括其相对于所生成的虚拟SR网格环境的位置和方向。所述视点探测器354提供的位置和方向信息与所述组合环境视图数据352一起使用,以显示基于所述设备306的位置和方向的虚拟SR网格环境的视场。

随着设备306的位置和方向的变化,显示的视图可以改变,从而对应于位置和方向的变化。

远程MR设备306包括用户输入接口356。所述用户输入接口356使得所述设备306的用户能够生成用户输入数据,并将所述用户输入数据作为反馈数据326通过所述网络接口348发送到所述网络304的本地MR设备。

可选地,用户输入接口356包括麦克风或其他音频捕获接口,使得设备306的用户能够捕获语音或其他音频数据以作为反馈数据326发送到本地MR设备。

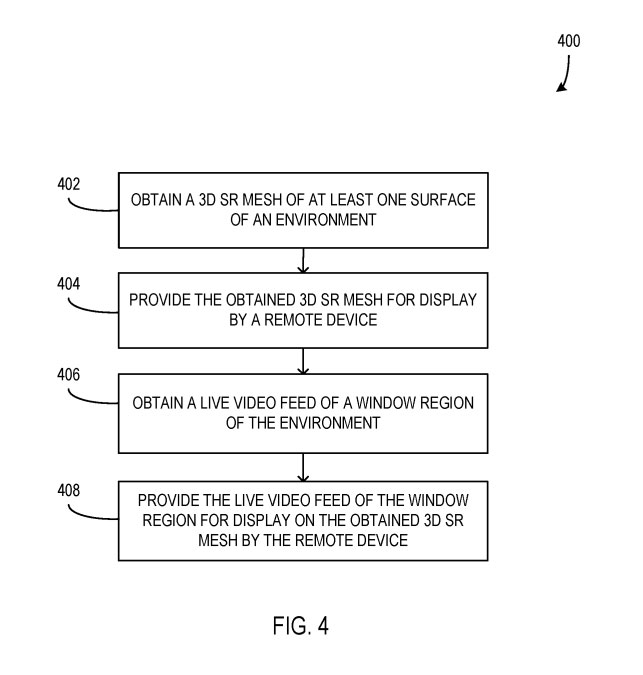

图4示出用于向远程设备提供组合的SR网格数据和实时视频数据,以使远程设备能够显示MR环境。

在402,获得环境表面的3D SR网格。3D SR网格包括一系列位于3D空间中的点,而点相互连接,以表示环境的3D表面。

在404,所获得的3D SR网格提供给远程设备显示。

在406,由本地MR设备获得环境窗口区域的实时视频馈送。实时视频馈送包括与本文所述环境的特定窗口区域相关联的视频数据。

在408,窗口区域的实时视频馈送由远程设备提供在3D SR网格上显示。

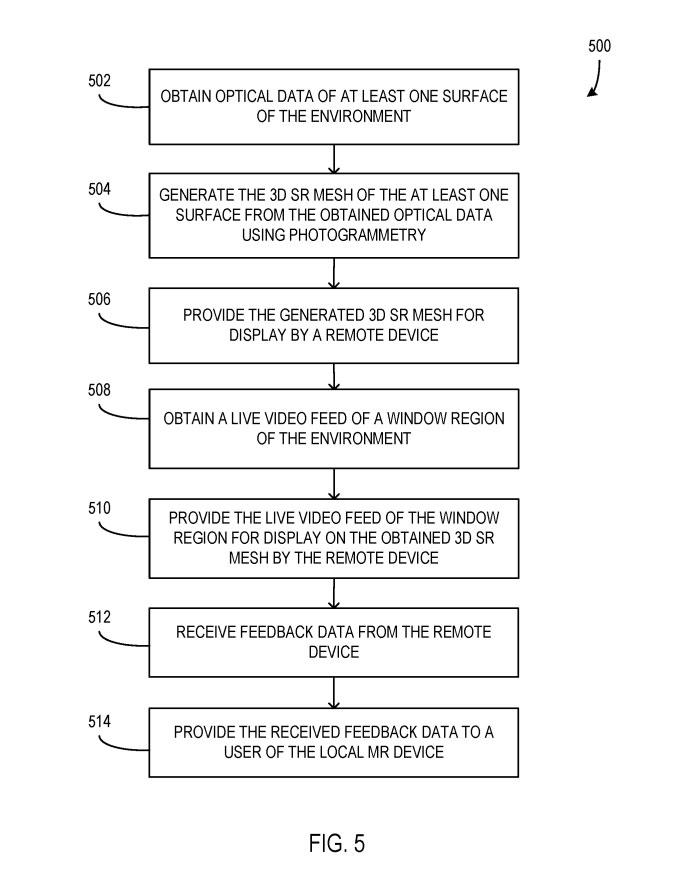

图5示出的计算机化方法500的用于向远程设备提供组合的SR网格数据和实时视频数据,以使远程设备能够显示MR环境,并根据所提供的SR网格数据和实时视频数据从远程设备接收反馈数据。

在502,由本地MR设备获得环境表面的光学数据。

在504,使用摄影测量从获得的光学数据生成表面的3D SR网格。

在506,生成的3D SR网格由远程设备提供显示。

在508,获得所述环境的窗口区域的实时视频馈送。

在510,提供所述窗口区域的实时视频馈送以供远程设备在3D SR网格上显示。

在512,从远程设备接收反馈数据。

在514,将接收到的反馈数据提供给本地MR设备的用户。

方法500进一步包括通过本地MR设备的可视界面向本地MR设备的用户显示与实时视频馈送相关联的窗口区域的位置。

另外,获取窗口区域的实时视频馈送包括从至少一个与本地MR设备分离的本地光捕获设备获取实时视频馈送。实时视频馈送包括来自多个本地光捕获设备的多个实时视频馈送。

名为”Mixed reality environment display using surface reconstruction mesh and live video overlay“的微软专利申请最初在2022年2月提交,并在日前由美国专利商标局公布。