纽约大学基于HoloLens 2开发AR+AI虚拟助手,提供及时音视频反馈

利用微软HoloLens 2,人工智能虚拟助手会直接在用户视场提供及时的视觉和音频反馈

(映维网Nweon 2023年09月27日)如果你学过做饭,你就会知道这对新人而言并不简单。但想象一下,如果你有一个人来帮助你,比如说一个人工智能助手可以指导你完成所有你需要知道的事情和完成的动作,这将能确保你没有任何遗漏,并协助你享受一顿没有压力的美味晚餐。

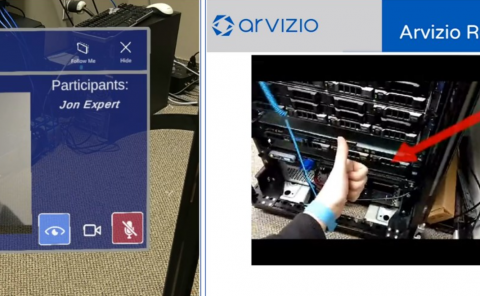

对于由纽约大学可视化成像和数据分析中心(Visualization Imaging and Data Analytics/VIDA)的计算机科学、工程和数据科学教授克劳迪奥·席尔瓦(Claudio Silva)领衔的团队,他们正在开发一种AR+AI的解决方案。其中,利用微软HoloLens 2,人工智能虚拟助手可以直接在用户视场提供及时的视觉和音频反馈。

尽管烹饪是项目的一环(在低风险环境中提供概念验证),但相关研究为有朝一日应用于从指导机械师完成复杂维修工作到在战场执行救生手术的战斗医务人员等各种领域奠定基础。

据介绍,所述项目获得了美国国防高级研究计划局DARPA的资助。在一份价值500万美元的DARPA合同的支持下,纽约大学的研究小组正在开发通过AR来帮助人们执行复杂任务,同时扩展他们技能的AI技术。

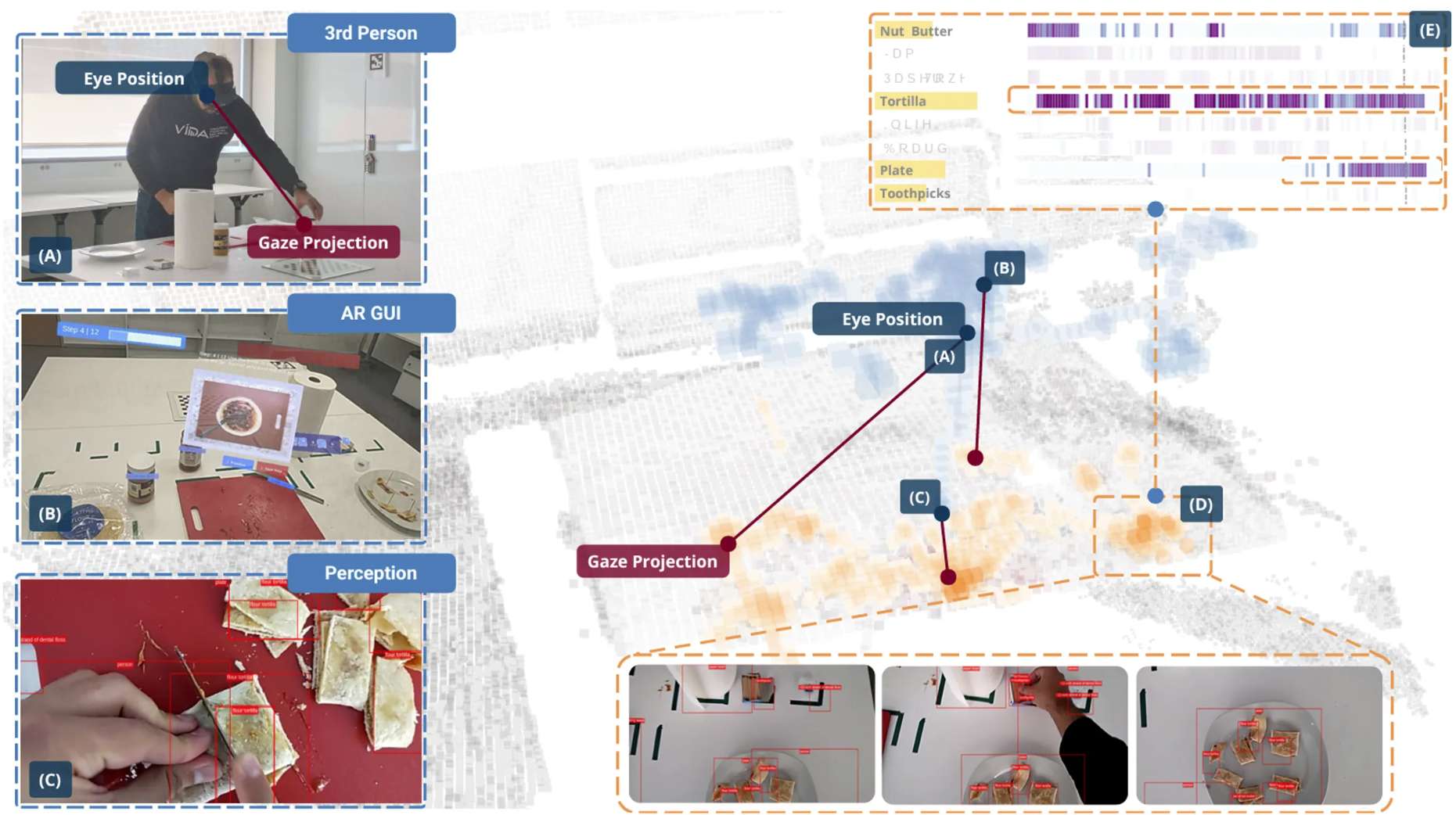

纽约大学的研究小组一直在对知识转移、感知基础、感知注意力和用户建模进行基础研究,从而创建一个与用户交互,并且不仅对环境做出反应,同时可以对用户的情绪状态、位置、周围条件等做出反应的动态智能代理。

席尔瓦称其为“类固醇清单”,并表示项目旨在开发透明、可解释和多模式个人助理。系统可以“看到”和“听到”用户看到和听到的内容,解释时空背景,并通过语音、声音和图形提供反馈。

尽管项目的初始应用用例主要用于军事应用,如辅助医务人员和直升机飞行员,但无数的其他场景可以从这项研究中受益。

席尔瓦指出:“我们的愿景是,当有人在执行某项操作时,这个智能代理不仅可以指导他们完成手头任务的程序步骤,而且可以自动跟踪过程,并感知环境中发生的事情和用户的认知状态,同时尽可能不引人注目。”

所述项目汇集了来自计算机领域的研究人员,包括可视化、人机交互、增强现实、图形、计算机视觉和自然语言处理等,涉及14名纽约大学的教职员工和学生。另外,项目使用微软Hololens 2增强现实系统作为硬件平台测试平台。

席尔瓦表示,由于Hololens 2头显配备了一系列摄像头、麦克风、激光雷达扫描仪和惯性测量单元传感器,所以是系统的理想实验平台。

他解释道:“集成Hololens将允许我们能够向我们正在开发的智能代理提供大量输入数据,使其能够‘理解’静态和动态环境。”这位负责人进一步补充道,Hololens传感器阵列产生的大量数据需要集成远程人工智能系统,这需要在头显和远程云计算之间建立非常高速、超低延迟的无线连接。

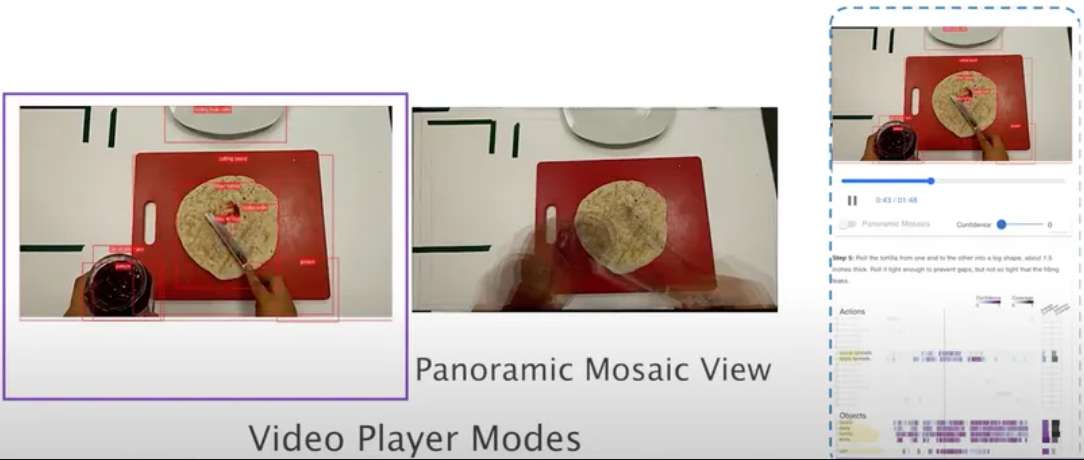

为了磨练系统的能力,团队将对它进行训练,让它学习一个高度依赖于正确、循序渐进地完成离散任务的过程:烹饪。在这个基于视频的训练过程中,一个关键因素是“教导”系统通过解释视频帧来定位演示过程中每个动作的起点和终点。

这个团队已经取得了巨大的进展。他们的重要论文《ARGUS: Visualization of AI-Assisted Task Guidance in AR》在IEEE VIS 2023大会获得了最佳论文荣誉奖(提出了一种名为ARGUS的视觉分析系统来支持智能助手的开发)。

相关论文:ARGUS: Visualization of AI-Assisted Task Guidance in AR

所述系统是可视化研究人员与机器学习和AR专家多年合作的一环。它允许对象、动作和步骤检测的在线可视化,以及先前记录的AR会话的离线分析。它不仅可以可视化多模态传感器数据流,同时可以可视化机器学习模型的输出。这允许开发者深入了解执行者活动以及机器学习模型,帮助他们排除故障、改进和微调助手的组件。

席尔瓦指出,DARPA的项目专注于以人为中心和数据密集型计算,而这正是VIDA所做的工作的核心:利用先进的数据分析和可视化技术来阐明影响一系列关键社会重要性领域的潜在因素。

他表示:“我们目前的大多数项目都有人工智能组件,而我们所做的事情是真正为现实世界应用设计,是供人们实际使用的系统,而不是作为理论练习。”