微软AR/VR专利分享在移动平台追踪实体的3D位置方向的方法

在移动平台中使用HoloLens

(映维网Nweon 2023年10月18日)以前,当在慢速移动的船舶或列车中使用HoloLens时,若先转身然后再回过来,追踪不是非常稳定,你会看到全息图的残影痕迹。所以,微软为HoloLens带来了Moving Platform Mode移动平台模式,从而允许用户在移动平台中使用设备,如相对缓慢移动的船舶。

利用这个功能,用户将能够在移动平台正常使用HoloLens,因为全息影像能够稳定地保持在原位。

对于这一点,美国专利商标局日前公布了一份与之相关的微软专利申请“Tracking in a moving platform”。概括来说,专利描述了一种在移动平台追踪实体的3D位置和方向的方法。

在一个实施例中,所述方法包括接收由安装在实体上的惯性测量单元感测的数据;接收从描绘移动平台或移动平台中的实体的图像计算的视觉追踪数据;通过使用视觉追踪数据和惯性测量单元感测的数据估计多个状态来计算实体的3D位置和方向,其中状态包括移动平台的状态和实体的状态。

其中,设备搭载的融合器可以同时考虑移动平台和实体的状态。通过这种方式,融合器能够支持移动平台并提高追踪性能。

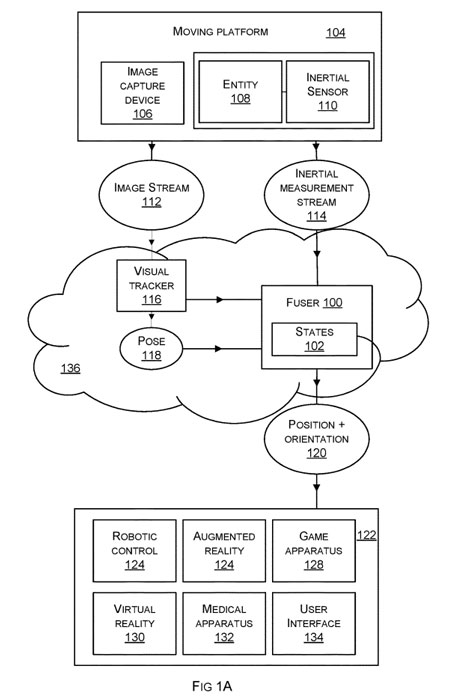

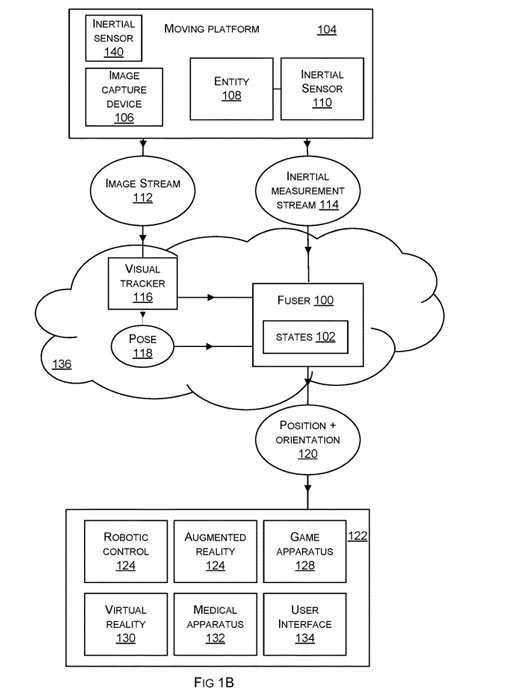

图1是作为云服务部署的融合器100的示意图,其用于计算移动平台104中的实体108的3D位置和方向以及可选的其他参数,例如速度、加速度、重力。移动平台的例子有轮船、飞机、电梯、汽车、公共汽车、有轨电车、火车、宇宙飞船、空间站、潜艇等

融合器从两个或多个独立的源获取输入,包括惯性测量单元IMU感测的数据,以及视觉追踪数据,其是从描绘所述移动平台或所述移动平台中的实体的图像流112计算的3D位置和方向数据。

与其他方法不同的是,融合器同时考虑了移动平台和实体的状态。通过这种方式,融合器能够支持移动平台并提高追踪性能。

如图1所示,实体108位于移动平台104内,并且实体具有称为实体IMU的惯性传感器110。实体IMU挂载在实体108之上。

至少一个图像捕获设备106安装在实体108上或安装在移动平台104上,并捕获描绘所述实体的视场的图像。

来自图像捕获设备106的图像流112传送到视觉追踪器116,在图1A的示例中,视觉追踪器116与融合器100一起部署在云中。视觉追踪器从图像流112计算实体的3D位置和方向。

在一个示例中,视觉追踪器具有移动平台的3D模型,并通过使用优化将观察到的数据拟合到模型来计算实体的姿态118。所述移动平台的3D模型是预先可得的或由所述视觉追踪器从所述图像流112计算得到。任选地,将融合器100计算的数据反馈给视觉追踪器116,以改善视觉追踪器116的操作。由融合器100计算的数据用于校正视觉追踪器116输出中的漂移。

融合器100的输出包括实体108的3D位置和方向120以及可选的其他参数,例如速度、加速度、重力中的一个或多个。

在图1A的实施例中,视觉追踪器116和融合器100部署在云或与图像捕获设备106和实体IMU通信的任何通信网络136中。在其他实施例中,视觉追踪器116和融合器100的功能在实体108和云部署之间共享。在其他实施例中,视觉追踪器116和融合器100与实体108成一体。

通过同时考虑移动平台的状态和实体的状态,融合器以一种非常规的方式工作,从而准确追踪移动平台上实体的3D位置和方向。

在图1A的实施例中,融合器在计算实体108在移动平台104上的三维位置和方向时,能够考虑移动平台的状态以及实体的状态。与只考虑实体108的状态或不考虑移动平台的状态的方法相比,其结果是对移动平台上的实体108的更准确的追踪。

在图1A的实施例中,尽管所述融合器考虑了所述移动平台的状态,但所述融合器具有关于所述移动平台状态的有限观测数据。在图1A的情况下可用的观测数据包括来自实体IMU的图像流112和惯性测量流114。

因此,观测到的数据与移动平台本身几乎没有关系。因此,由融合器从可用的观测数据推断出运动平台的状态。

图1B与图1A相同,除了有一个额外的IMU。在图1B的例子中。融合器100使用平台状态和实体状态。融合器接收惯性测量流114,流114包括来自实体IMU的数据以及来自平台IMU的数据。来自平台IMU的数据是关于融合器100所使用的平台状态的观测数据。来自平台IMU的数据包括相对于平台IMU的坐标框架的测量。

因此,融合器将来自平台IMU的数据转换为与其计算相兼容的坐标系。

由于融合器100现在具有关于平台状态的观测数据,因此与推断平台状态的图1A的实施例相比,追踪的准确性得到了改进。

通过在平台的不同位置添加更多平台IMU,可以对图1B的示例进行扩展。融合器100能够使用来自所有平台IMU的数据,或者选择在给定时间最接近实体的一个或多个平台IMU。

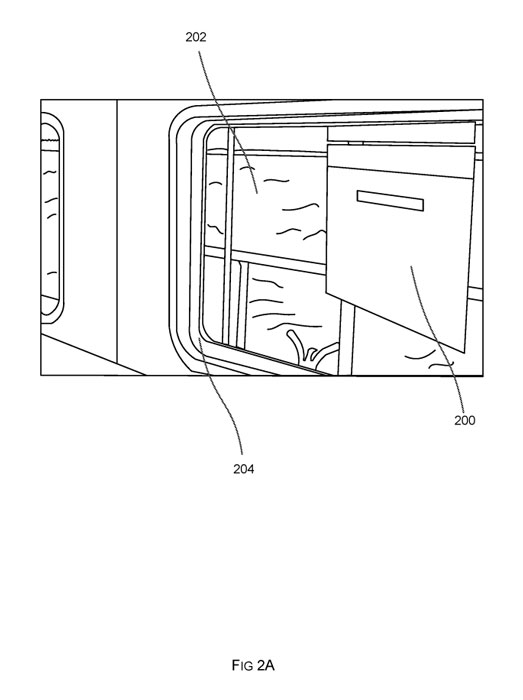

图2A显示了一个应用场景。其中,移动平台是一艘船,并且头戴式显示器的追踪位置和方向用于放置平台锁定的全息图200。穿戴头显的用户在船上,并且透过窗户可以看到海洋。考虑到头戴式显示器追踪的3D位置和方向,用户能够看到由头戴式显示器投影的用户界面的全息图200。

如上所述,即便头戴式显示器位于移动平台之上,都可以通过考虑平台状态(即船舶状态)和融合器中的实体状态(即头戴式显示器状态)来准确地追踪3D位置和方向。

头戴式显示器有一个IMU,它向融合器输入数据。头戴式显示器具有图像捕获设备,其将图像流输入到参照图1A所述的视觉追踪器。视觉追踪器的输出与头戴式显示器IMU的数据一起进入引信。

全息图200属于平台锁定,因为它看起来相对于船的内部是固定。平台锁定通过使用头戴式显示器的追踪3D位置和方向来确定如何投影全息图200来实现。

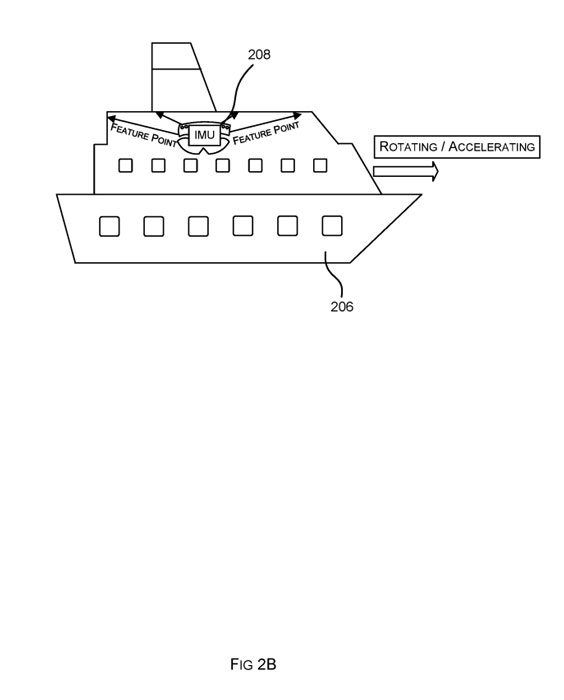

图2B是船舶206和头戴式显示器208的示意图。船206正在加速和/或旋转,而船上的头戴式显示器208是静止的。头戴式显示器208的图像捕获设备捕获船舶206内部的图像,并将其输入到计算头戴式显示器208的固定3D位置和方向的视觉追踪器。

头戴式显示器208中的IMU感知船舶加速度和/或旋转。头戴式显示器208中的IMU和视觉追踪器的信息相互冲突,导致数据不一致,而这往往导致追踪丢失。所以,微软提出的融合器可以应对这种问题。

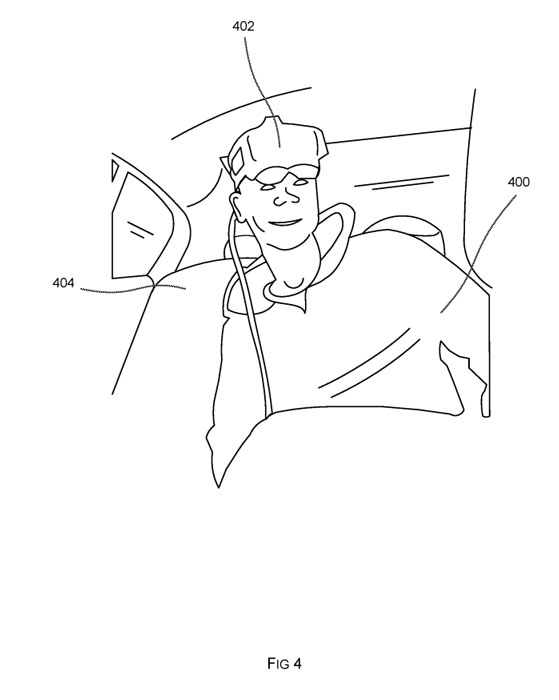

图4是机动车辆404中的乘客400示意图。其中,乘客戴着头戴式显示器402,汽车正在行驶。因此,在移动平台(机动车辆404)上存在实体(头戴式显示器402)。

头戴式显示器402可以是混合现实可穿戴计算机,如微软HoloLens,并包含IMU和至少一个图像捕获设备,以捕获头戴式显示器402的视场图像。

头戴式显示器402包含视觉追踪器116和融合器100。融合器在计算头戴式显示器的三维位置和方向时,同时考虑头戴式显示器的状态和机动车辆的状态。

融合器使用来自视觉追踪器的结果以及IMU在头戴式显示器402中感知的数据。由于融合器考虑了头戴式显示器的状态和机动车辆的状态,因此它能够在机动车辆运动的情况下以准确的方式追踪头戴式显示器的3D位置和方向。

尽管机动车辆在运动,但所述方法使得头戴式显示器能够投射看起来是平台锁定的全息图,即固定到机动车辆中的3D位置。

图4的示例通过具有包含IMU的移动计算设备的乘客进行扩展。乘客将移动计算设备放置在机动车辆的固定位置。平台IMU(即移动计算设备中的IMU)感知到的数据通过无线通信、有线连接、通过其他计算设备或以其他方式传输到头戴式显示器。

头戴式显示器402中的融合器能够利用平台和实体状态,从IMU数据和从视觉追踪数据准确地追踪头戴式显示器402的3D位置和方向。

如果融合器使用的状态包括平台IMU的3D位置和方向以及平台IMU的速度,两者都以世界参考系表示,则头戴式显示器就能够投射出锁定世界的全息图。在这个例子中,世界锁定全息图是在移动的汽车之外的环境中出现的全息图,例如道路上的全息图。

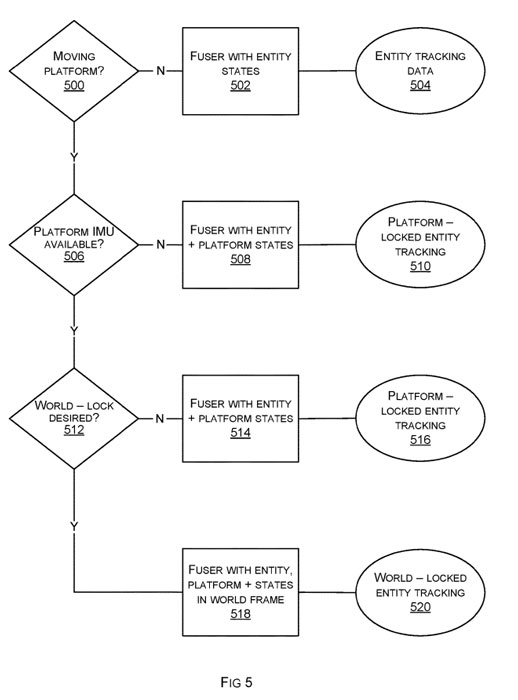

图5是由融合器100用于追踪移动平台中的实体的流程图。

在500,评估是否进入移动平台模式。

在502,融合器仅以实体状态运行,并从实体IMU数据和视觉追踪数据计算实体追踪数据504。在常规模式下,由于没有移动平台,实体追踪数据504是准确的。

在504,当满足一个或多个标准时,融合器进入移动平台模式。

在506,当融合器进入移动平台模式时,检查平台IMU数据是否可用。如果不是,则融合器操作508实体状态和平台状态。合理的平台锁定实体追踪510利用实体IMU数据和视觉追踪数据实现。

在506,其中平台IMU数据对融合器可用,融合器继续检查是否需要在检查512处进行世界锁定。如果不需要世界锁定,则融合器与实体和平台状态514一起操作,并且除了实体IMU数据和视觉追踪数据外,进一步使用平台IMU数据。融合器计算平台锁定实体追踪516,尽管平台运动,但精度很高。

在512,如果需要世界锁定,则融合器使用518个实体状态、平台状态和世界参考框架中的状态。除实体IMU数据和视觉追踪数据外,融合器同时使用平台IMU数据计算世界锁定实体追踪520。

名为“Tracking in a moving platform”的微软专利申请最初在2023年5月提交,并在日前由美国专利商标局公布。