微软AR/VR专利介绍一种利用融合深度传感的全身追踪方法

全身追踪

(映维网Nweon 2024年01月05日)目前大多数基于XR一体机的Avatar系统都没有下半身。一个重要的原因是,尽管设备能够通过摄像头覆盖和算法补充来精确追踪上半身,但基本没有摄像头视场覆盖的下半身只能通过算法进行估计判断。随着头显形状参数的不断小型化轻薄化,摄像头的视场覆盖问题将会变得越发困难。

不过,诸如Meta,苹果和微软等巨头都在积极探索相关的解决方案。例如在名为“Full body tracking using fusion depth sensing”的专利申请中,微软就介绍了一种利用融合深度传感的全身追踪方法。

微软指出,为了提供真正身临其境的MR体验,需要对真实物理中的用户和对象进行精确的运动追踪。例如,可以通过可穿戴设备的雷达传感器设备来检测、测量和/或追踪对象的位置。每个雷达传感器可以生成、捕获并评估与可穿戴设备和周围环境相关的雷达信号。在视场内具有足够反射率的对象将产生具有特征到达时间(TOA)、到达角(AOA)和频移(多普勒频移)的雷达返回信号。

然后,可以对感知到的返回信号进行处理,从而确定距离和方向,并根据目标的雷达特性识别目标。另外,包括位置和识别的对象信息可以基于与来自一个或多个数字摄像头或惯性测量单元的测量的相关性进一步解析。

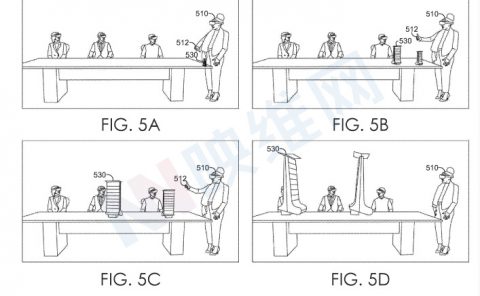

微软表示,这种解决方案不需要任何特定的身体穿戴控制器或反射器,并且可以追踪包括环境元素(例如墙壁,地板,天花板或房间对象)和用户的特定身体部位,例如手,脚,腿,躯干,头和肩膀等。

换句话说,基于雷达的测量可以与来自诸如摄像头设备或IMU等其他组件的测量相结合,以便利用深度感测测量的相关性和融合来改进目标追踪。其中,被追踪的对象可以包括用户的全身追踪。

腿、脚、躯干和头部位置都可以通过雷达传感器设备的位置和方向来追踪,从而实现3D元宇宙中的全身追踪。另外,由于雷达传感器可以配置为检测地面、墙壁和天花板,所以可以消除对地面检测和校准的需求。

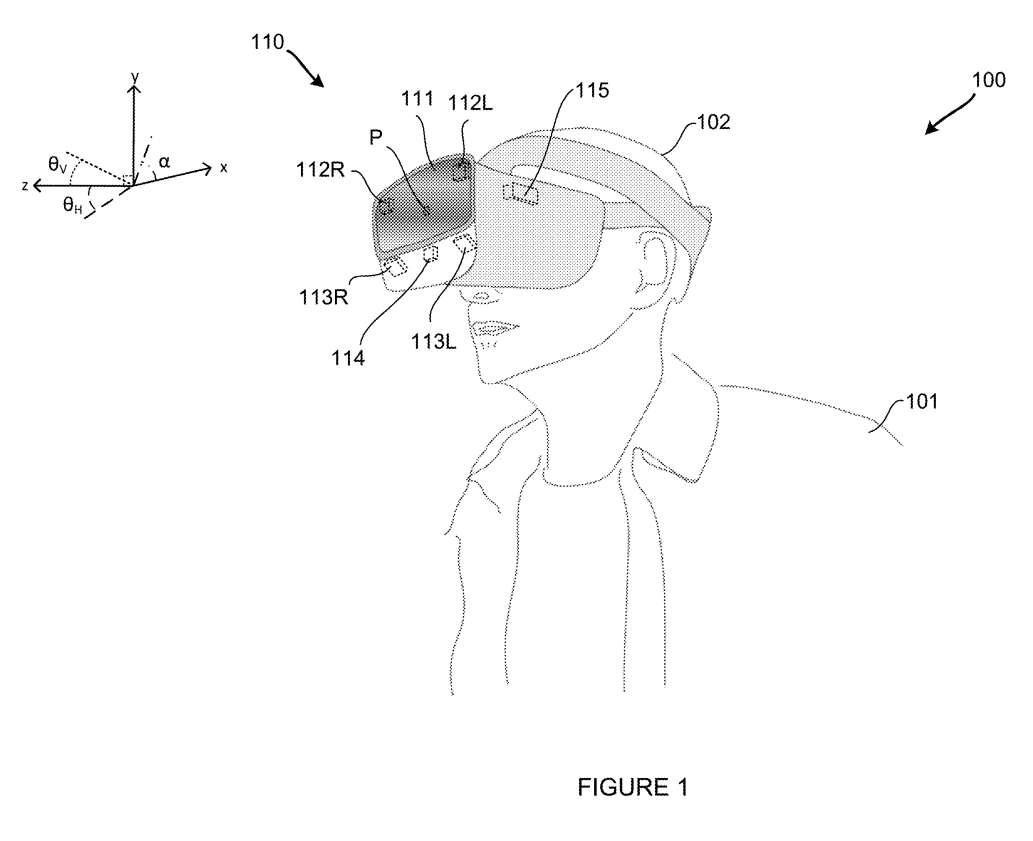

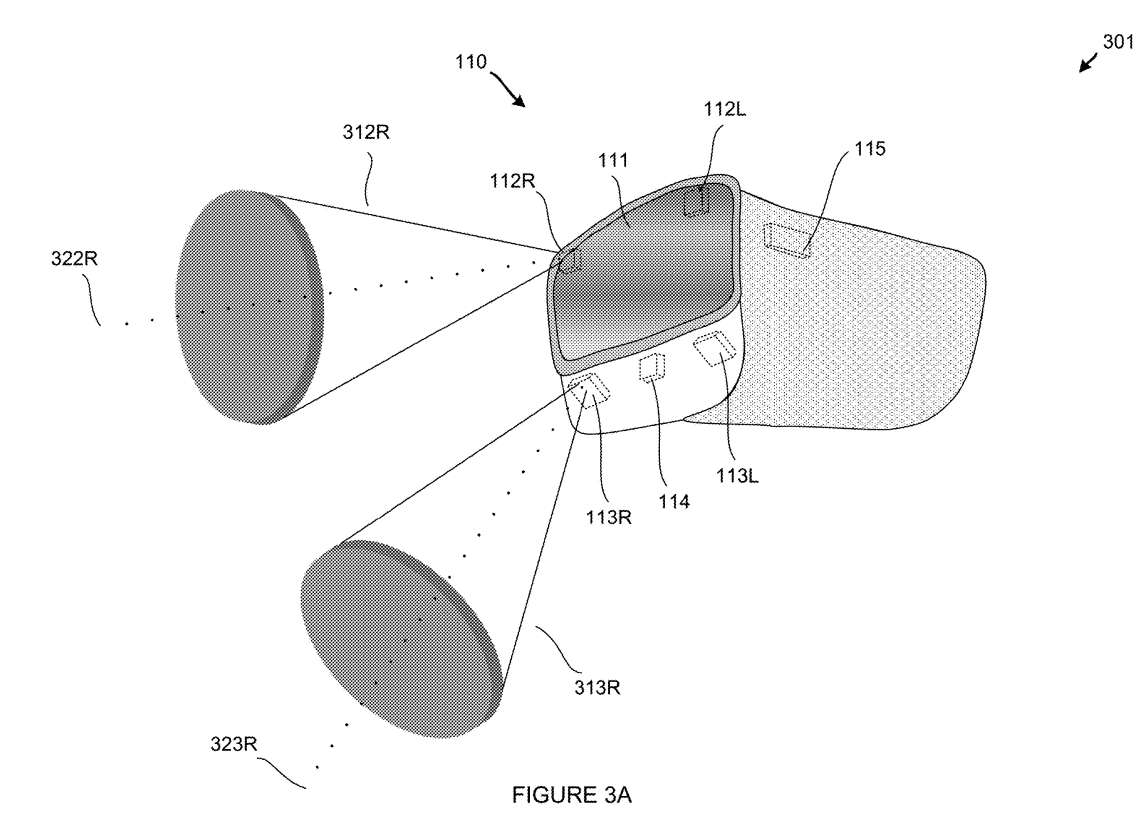

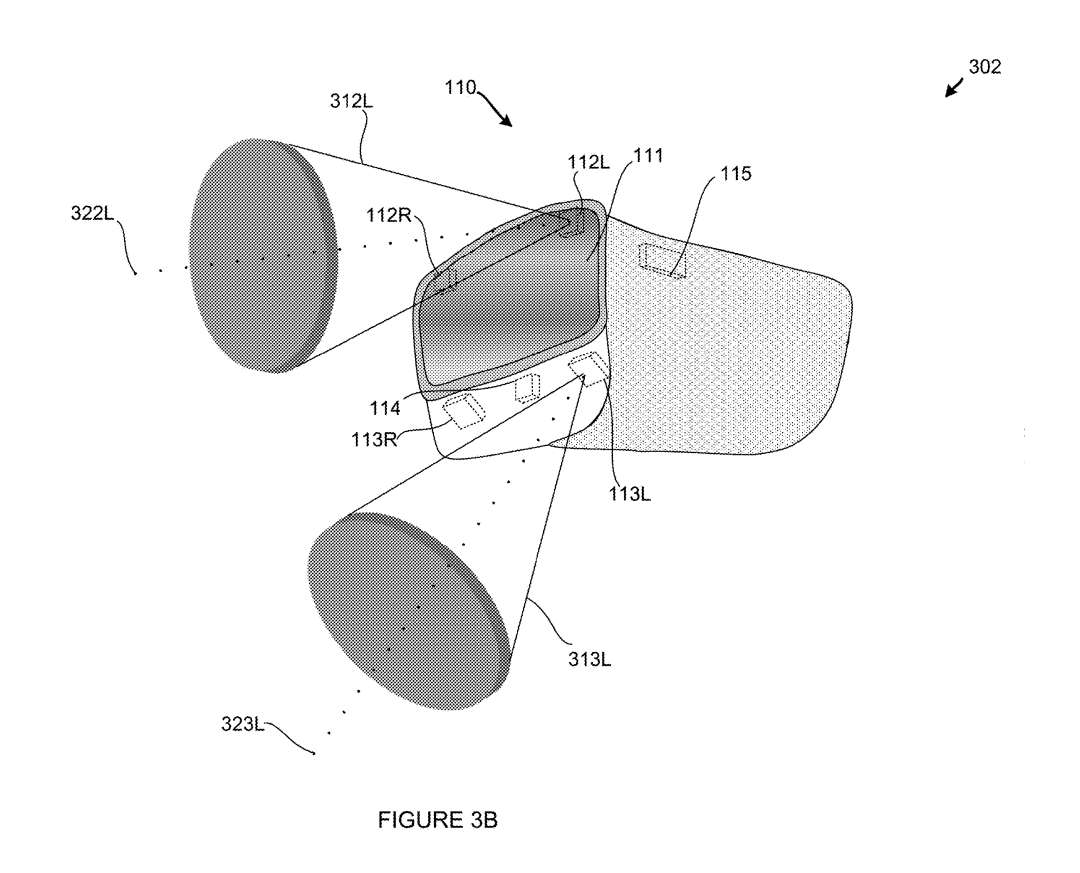

图1是佩戴头戴式显示设备110的用户101的透视图100。传感器设备112R、112L、113R和113L可以对应于配置为提供与头显110和周围环境相关的雷达测量的雷达传感器。传感器112R、112L、113R和113L分别位于头显 110的不同物理位置,因此每个传感器具有不同的视场。基于传感器的位置,所有传感器112R、112L、113R和113L的组合视场可以重叠或不重叠。

头显110每个雷达传感器112和113的精确位置可以水平和垂直变化。每个传感器112和113相对于x轴和y轴的旋转角度可以改变。另外,可以相对于z轴改变传感器112和113的每个的角度倾斜位置,以便可以改变相应传感器的视场方向。

在一个实施例中,传感器设备112R、112L、113R和113L中的一个或多个同时可以包括配置为基于头显110的位置和方向捕获惯性测量的一个或多个惯性测量单元IMU共存。在另一个示例中,传感器设备112R、112L、113R和113L中的一个或多个可以包括配置为捕获头显110周围环境的图像的一个或多个数字摄像头共存。

附加传感器114可以对应于另一雷达传感器、惯性测量单元、数码摄像头或照明设备。在一个示例中,附加传感器114是位于用户嘴唇上方的摄像设备。

图2A示出第一穿戴式设备200。可穿戴设备200包括四个传感器112L、112R、113L和113R。每个单独的传感器都可以对应于一个芯片上的雷达系统SOC,每个传感器都可以作为单片微波集成电路或MMIC实现。这种MMIC器件能够捕获雷达测量,并将雷达测量数据通信到应用处理器115。

在一个示例中,传感器113L通过SOC的第一个MMIC实现来说明。其中,SOC包括一个发射器(TX1) 221和三个接收器(RX1,RX2和RX3) 。如前所述,传感器113L可以对应于能够将雷达测量数据通信到应用处理器115的芯片上的完整雷达系统。

第二个示例传感器113R是SOC的第二个MMIC实现,所述SOC包括多个发射器221(TX1-TXL),多个接收器222 (RX1-RXM),多个223天线(ANT1-ANTN),以及用于RF,IF和基带处理224的附加电路224。可以利用更多数量的天线来增加传感器113R视场的整体尺寸。

附加电路的具体详细组件可以包括各种RF/IF和基带电路,用于控制不同RX和TX信号路径与选定天线之间切换的状态机和/或顺序器,用于通过天线传输雷达信号的功率放大器,用于捕获天线雷达返回信号的低噪点放大器等。

微软指出,这类雷达MIMIC器件越来越容易获得,包括英飞凌科技生产的毫米波雷达器件。设备中的每一个都包括完整的SOC功能,可以生成、捕获和评估位于相应天线视场内的雷达信号。

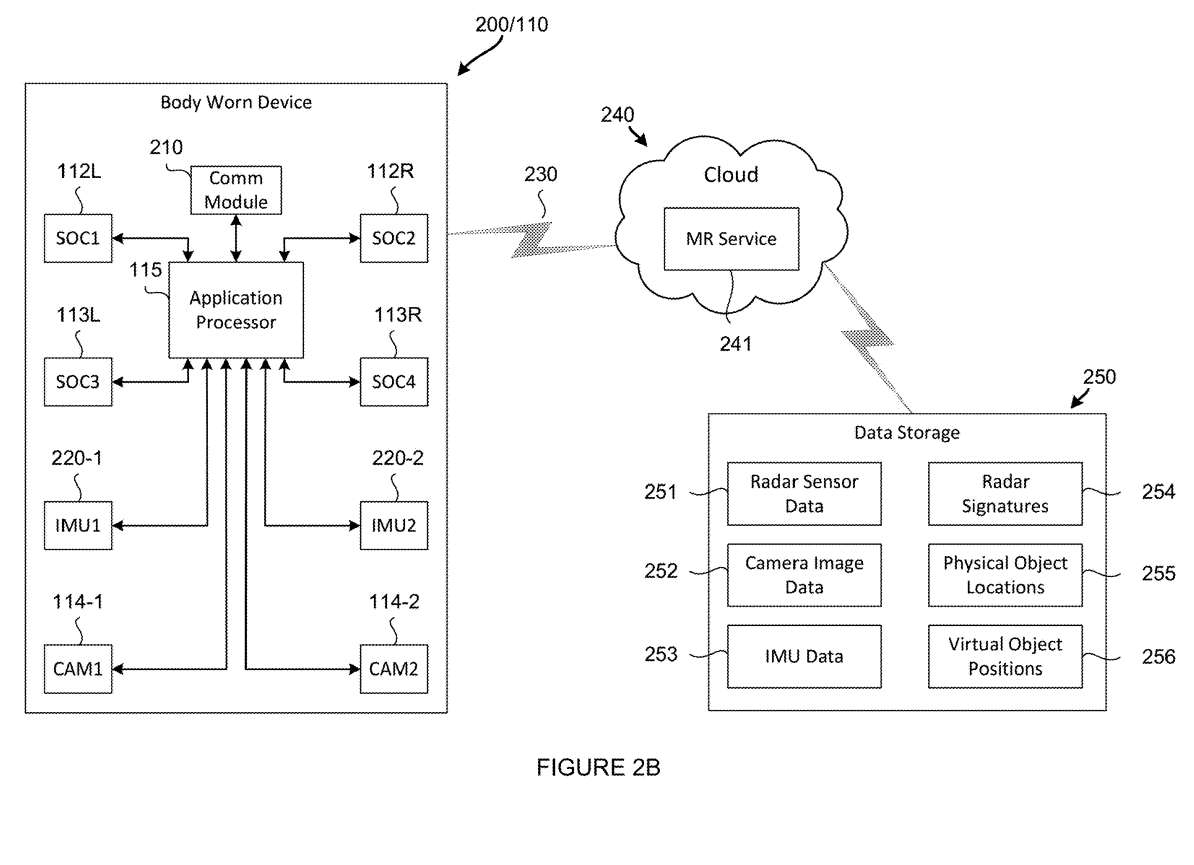

图2B示出的第二穿戴设备200配置为通过一个或多个基于云的服务协调对象的追踪。图2B的穿戴式设备200包括与图2A相同的基本部件,并增加了一个通信模块210、两个惯性测量单元220和两个摄像头设备114。

所描述的雷达传感器112L、112R、113L和113R中的每一个再次描述为一个芯上系统(SOC1到SOC4),它们各自生成、捕获和评估与可穿戴设备和周围环境相关的雷达信号。

视场内具有足够反射率的对象会产生雷达回波信号和相应的测量值,如距离、到达时间、到达角、频移(等。然后,雷达传感器测量可以通过应用处理器115的操作单独处理,或者通过应用处理器115和基于云的240服务241的组合操作处理,从而确定距离和方向,以及基于对象的雷达特征识别对象。

图2A中示出了示例MR服务241。如图所示,捕获的雷达传感器数据可由应用处理器115通信到基于云的服务240,其中应用处理器115和MR服务241之间的通信链路230可由通信模块210管理。

所述数码摄像头设备114-1和114-2可以配置为捕获图像。所捕获的摄像头图像的数据存储250可由基于云的240服务241促进。

惯性测量单元220-1和220-2可以配置为捕获相对于身体穿戴设备200的物理位置和方向的惯性测量。IMU测量的数据存储250可以通过基于云的服务来实现。

在特定MR实现中需要的对象信息可以对应于对象的识别。当雷达发射器处于活动状态时,发射波从发射器传播到目标,并根据不同的反射率特性以不同的数量从目标反射出去。雷达接收器接收并处理反射波,以确定诸如到达时间、到达角度、多普勒频移、距离等特性。

所述测量或雷达传感器数据给出目标的反射率特性的完整图像,所以应用处理器或MR服务241(或其组合)可以将来自雷达传感器数据251的测量的反射率特性匹配到雷达特征254之一。

对象位置同时可以至少部分地基于距离和来自雷达传感器数据的其他测量来确定。如果已知可穿戴设备110的用户的准确位置,则可以根据捕获的雷达传感器数据来准确确定对象的相对位置。

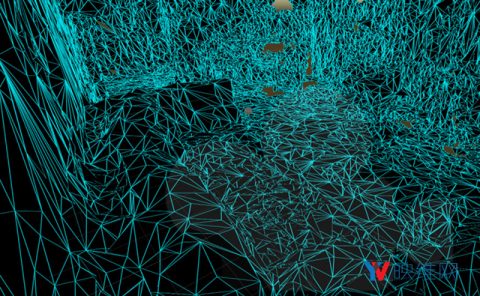

例如,可以配置一个或多个IMU设备来捕获惯性测量以确定头显110的精确方向;然后可用于在雷达SOC 112和113的视场内解析物理对象的精确位置。同样,摄像头图像数据可以与雷达传感器数据相结合,以将捕获的图像与其在物理世界中的位置紧密关联起来。根据位置和对象身份的测量,物理对象可以映射到3D虚拟空间中,以创建合并的AR环境。

图3B中示出诸如与设备110左侧相关联视场的附加特征。如图所示,位于左上方的传感器设备112L对齐以呈现一个视场312L。左上和左下传感器112L和113L对于其视场312L和313L可具有具有不同方向轴322L和323L的不同倾斜角。

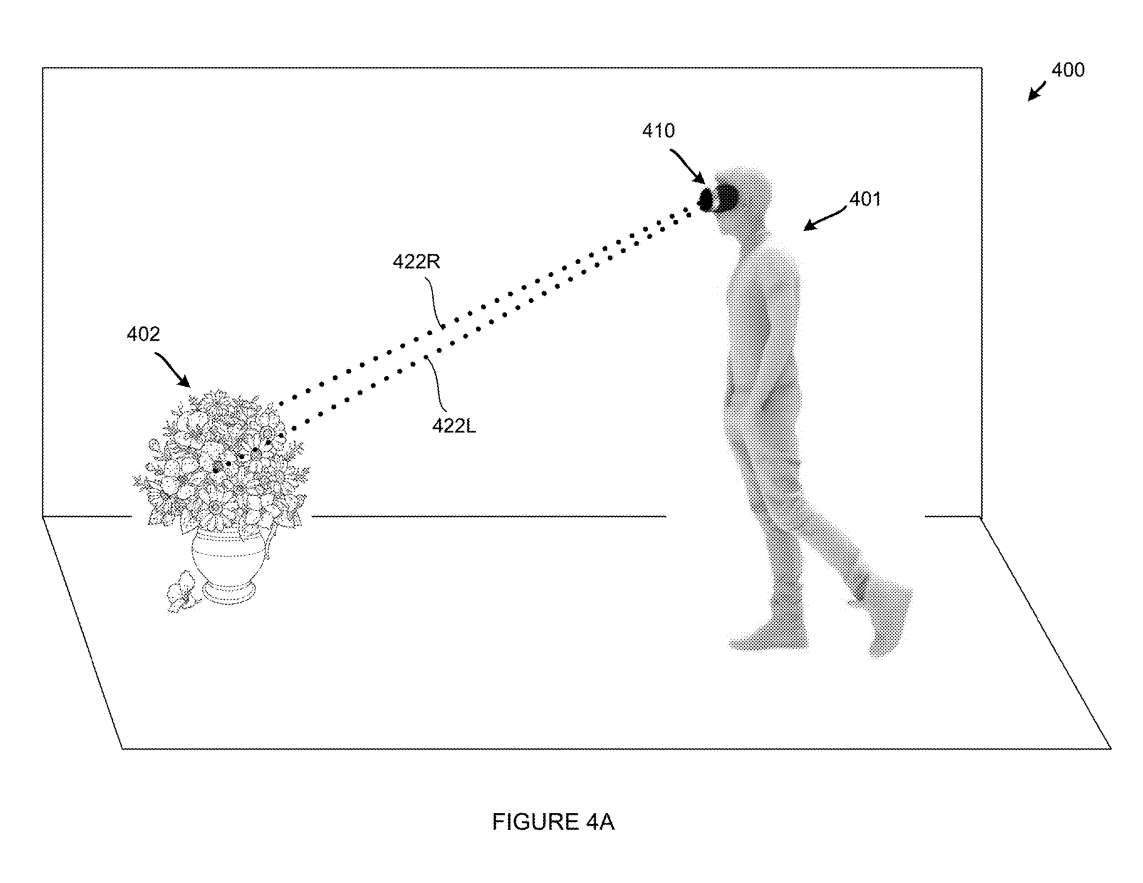

图4A是具有检测真实世界对象402的头戴式显示设备410的用户401的透视图400。如图所示,当用户401瞥向现实世界的对象402时,头戴式显示器的传感器沿着右侧的第一行瞄准镜422R对齐,沿着左侧的第二行瞄准镜422L对齐。因此,沿着对准轴投射两个雷达波束,致使相对于头显410的目标402的多波束雷达返回信号测量。

可以捕获雷达回波信号,而应用处理器可根据诸如飞行时间、到达时间、到达角度或到达角度、多普勒频移、信号强度、信号相位、估计方向或估计位置等各种特性测量将左右雷达回波信号聚类在一起。所述对象402相对于所述用户401的距离和位置可以从所述雷达返回信号精确地确定。

另外,目标类型可以由应用处理器通过雷达横截面或后向散射模式之间的相关性来识别。一旦知道用户当时的精确位置,就可以准确地确定对象402的精确位置,这可以通过来自其他设备的测量来确定,例如来自IMUS的惯性测量和/或来自数码摄像头的摄像头图像。

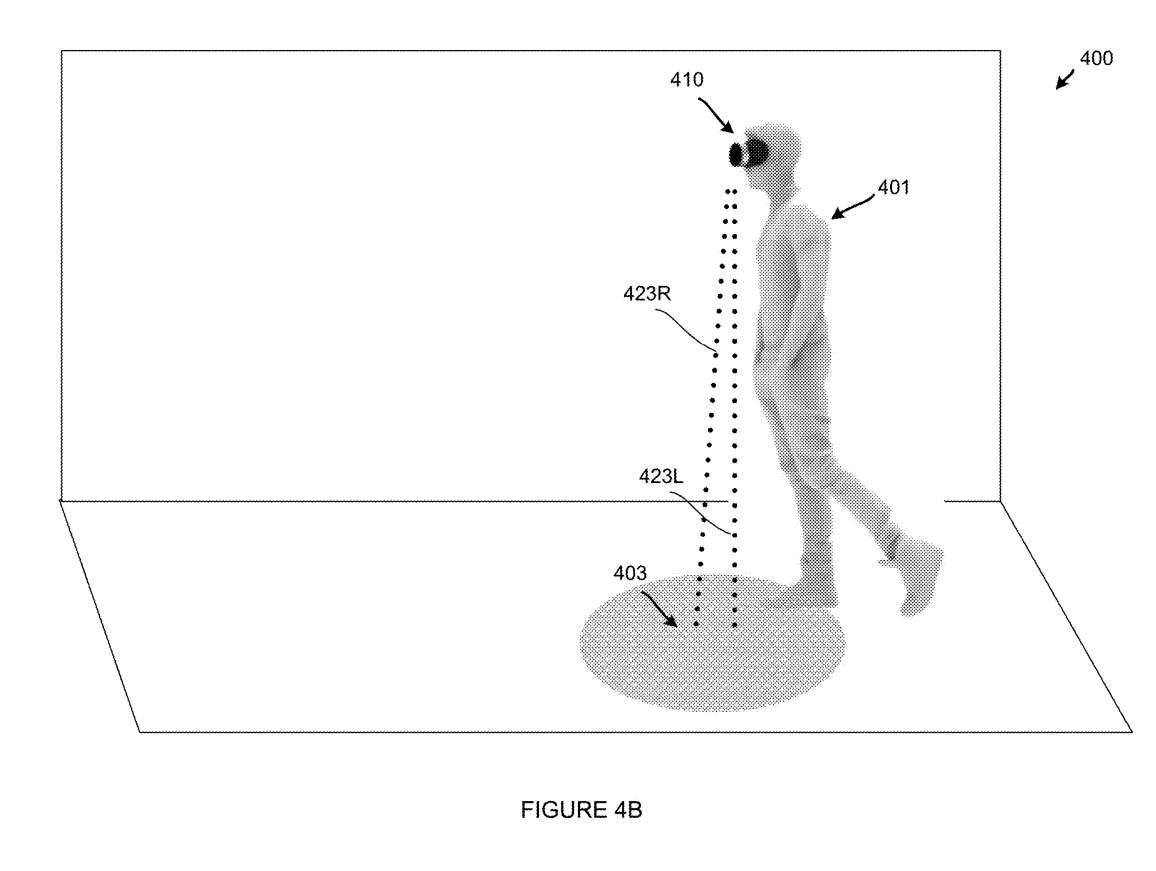

图4B是具有检测地板403的头戴式显示设备410的用户401的另一个透视图400。如图所示,当用户401扫视区域时,头显中的下传感器沿右侧的第一行瞄准镜423R对齐,沿左侧的第二行瞄准镜423L对齐。

因此,沿着对准轴投射两个雷达波束,致使相对于头显410的地面区域403的多波束雷达返回信号测量。由于地面区域具有较大的雷达目标区域,雷达回波信号强,这意味着后向散射高,因为入射雷达信号的很大一部分直接反射回发射天线。

雷达回波信号再次捕获,而应用处理器根据飞行时间、到达时间、到达角度、多普勒频移、信号强度、信号相位、估计方向或估计位置等各种特征将左右雷达回波信号聚类在一起。地板403相对于用户401的距离和位置可通过雷达回波信号准确确定。因此,用户401的高度可以快速准确地确定,无需任何额外的校准。

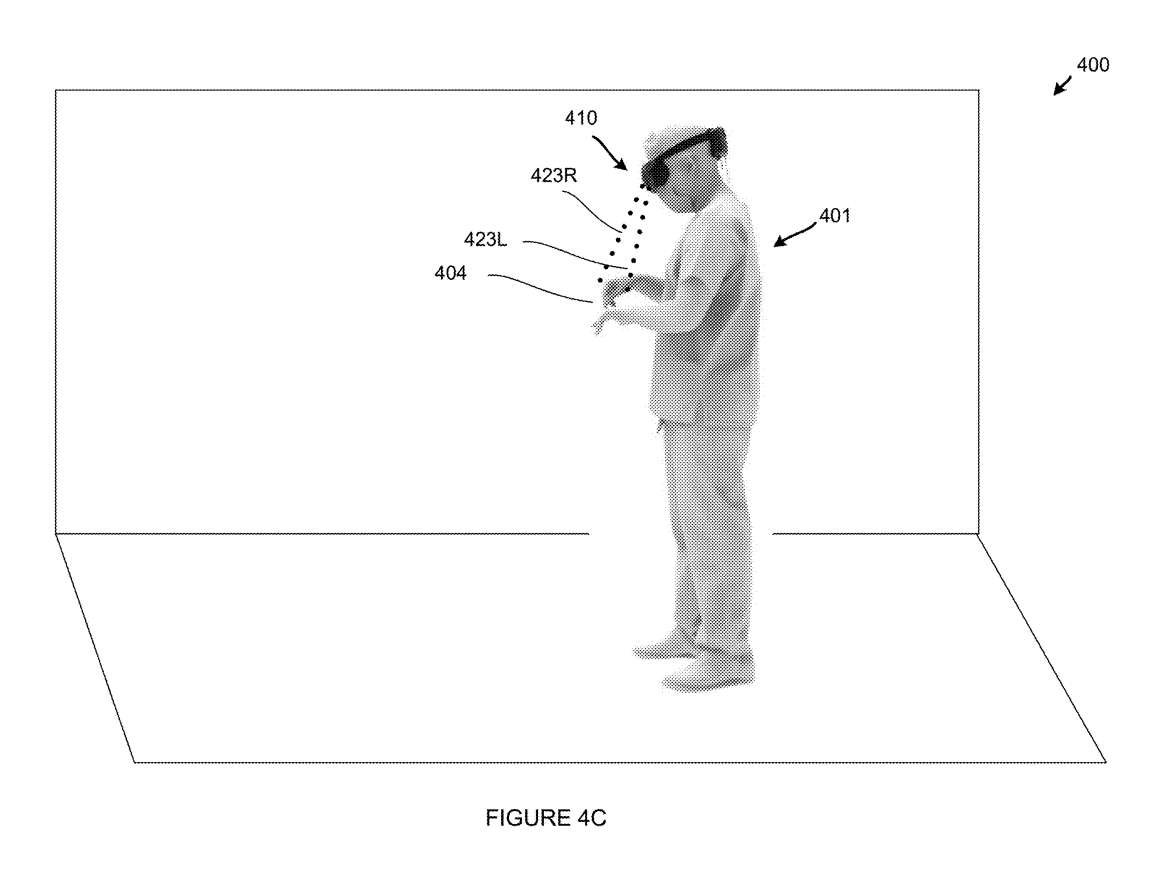

图4C示出头戴式显示设备410检测手404的位置。如图所示,当用户401在AR世界中扫视时,头显中较低的传感器沿着右侧的第一个瞄准线423R对齐,沿着左侧的第二个瞄准线423L对齐。因此,沿着对准轴投射两个雷达波束,致使相对于手404的多波束雷达返回信号测量。

可以捕获雷达回波信号,而应用处理器根据飞行时间、到达时间、到达角度、多普勒频移、信号强度、信号相位、估计方向或估计位置等各种特征将左右雷达回波信号聚类在一起。手404相对于用户401的距离和位置可以从雷达返回信号精确地确定。

另外,通过雷达反向散射模式与已知雷达特征之间的相关性,应用处理器可以将目标类型识别为人手。一旦知道用户当时的精确位置,就可以准确地确定用户的手404的精确位置,这可以通过其他设备的相关测量快速确定。

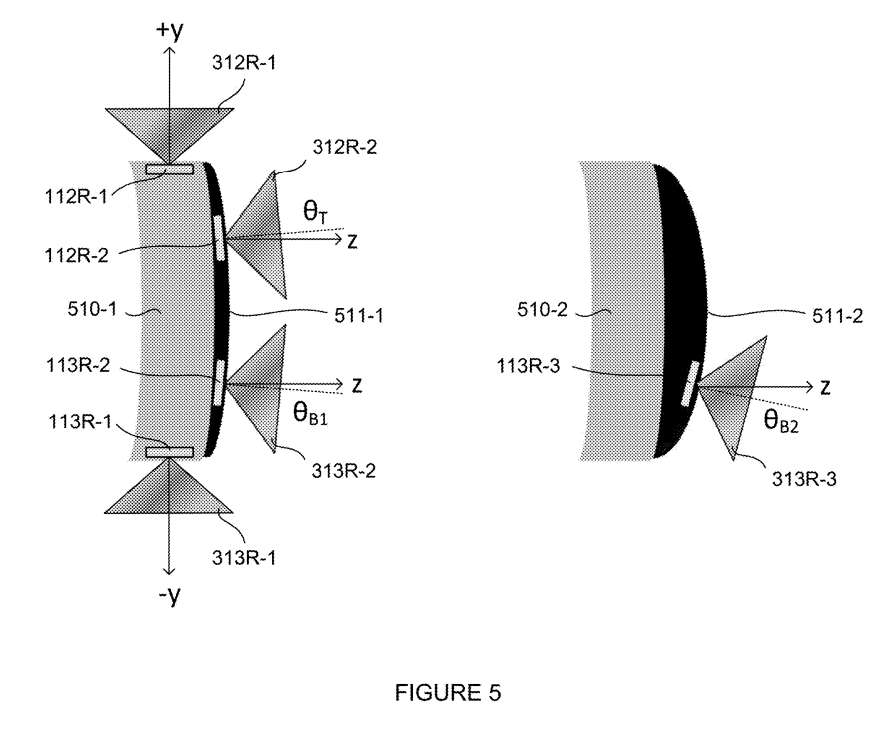

图5是头戴式显示设备的前部和传感器的可选位置和角度的侧面透视视图500。510-1和510-2显示了两种不同的显示设备类型。

第一显示设备510-1包括位于设备112R-1、112R-2、113R-1和113R-2右侧的四个示例传感器位置。

第一示例传感器112R-1位于头显510-1的上部或顶部区域,其中视场312R-1沿着y轴基本上向上指向。

第二示例传感器112R-2位于头显510-1的前面向表面511-1的上部或顶部,使得视场312R-2沿z轴以相对于z轴向上倾斜的角度θT指向前方。

第三个示例传感器113R-1位于头显510-1的大约较低或底部区域,其中视场313R-1沿y轴基本上向下指向。

第四例传感器112R-2位于头显510-1的前面向表面511-1的下部或底部,使得视场313R-2沿z轴以角度θB1指向前方。

第二显示设备510-2包括位于该设备右侧的示例传感器113R-3。所述显示设计在前面向表面511-2具有显著的曲率。传感器113R-3位于头显510-2的下部或底部区域,其中视场313R-3沿着z轴大致向前指向,并以相对于z轴θB1的角度向下指向。如图所示,平铺角度可以定位为匹配前面向表面的曲率。

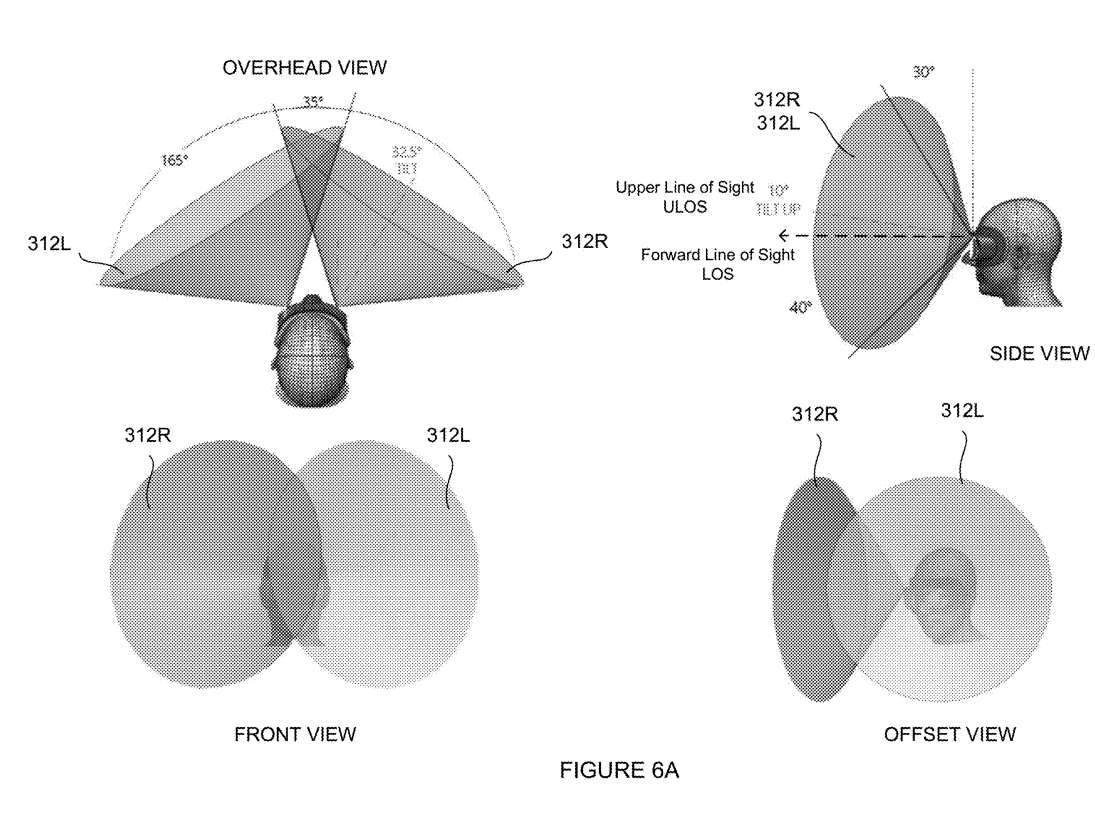

图6A示出了用于与示例头戴式显示设备中的一对传感器相关联的面向前方的透视视图600。在本例中,这对传感器等距地位于头显设备的左右两侧。

从俯视图和前视图可以看出,左侧312L视场与右侧312R视场在一个中心区域重叠,重叠度约为35度。合并后的视场距离俯视图约165度,其中每个传感器的位置从中心向右或向左倾斜约32.5度。

从正面和偏置视图来看,视场被观察到位于用户头部前方的中心位置,视场内基本上是圆形或锥形的捕获区域。从侧视图来看,视场相对于用户的前视方向向上倾斜约10度。因此,向上捕获区域对应于前方视线下方约40度的角度与前方视线上方约30度的角度。

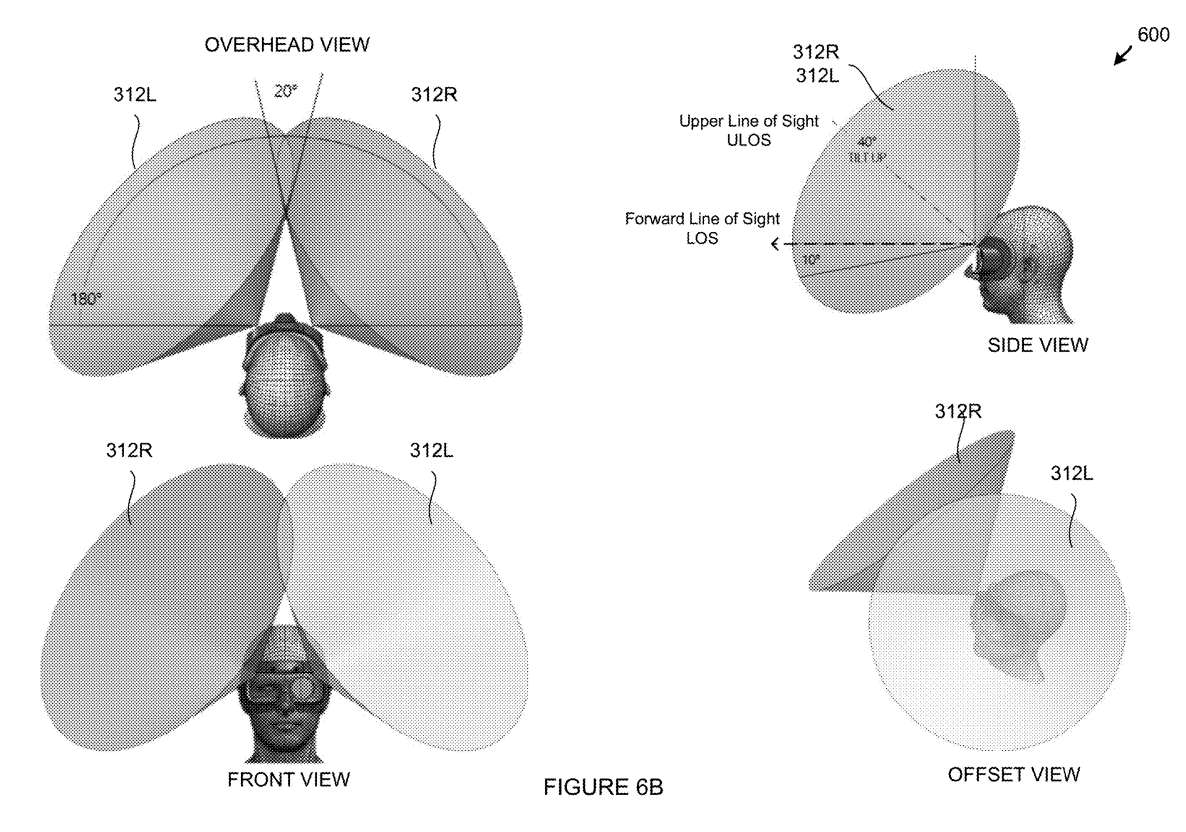

图6B示出了与示例头戴式显示设备中的上部或顶部传感器相关联的倾斜视场透视图。如图所示,这对传感器等距位于头显设备的左右两侧。

从俯视图和前视图可以看出,左侧312L视场与右侧312R视场在一个中心区域重叠,重叠度约为20度。合并的视场有一个捕获区域,与头顶视图约180度宽。

从正面和偏移视图来看,视场位于用户头部前方的中心并向上倾斜,在视场内具有基本上圆形或锥形的捕获区域。从侧视图来看,视场相对于用户的前视方向向上倾斜约40度。因此,向上捕获区域对应于前方视线下方约10度至前方视线上方约90度的角度。

图6C示出了与示例头戴式显示设备中的下部或底部传感器相关联的倾斜视图透视图。如图所示,这对传感器等距位于头显设备的左右两侧。从俯视图和前视图可以看出,左侧313L视场和右侧313R视场在一个中心区域重叠,重叠度约为30度。合并的视场有一个捕获区域,从头顶的视图约170度宽。

从前视图和偏移视图中,可以观察到视场位于用户头部前方的中央并向下倾斜,在视场内具有基本上圆形或锥形的捕获区域。从侧视图来看,视场相对于用户的前视方向向下倾斜约65度。因此,向下捕获区域对应于前方视线以下约15度至前方视线以下约115度的角度。

图6D示出了与示例头戴式显示设备的上、下传感器的重叠视场相关的透视图。如俯视图所示,在用户的上视线中,上视场312L和312R基本上向前,而下视场313L和313R在用户的下视线中是向下倾斜。因此,上方视场定位于捕捉用户上方视线内的对象,而下方视场313L和313R定位于捕获用户视线内的对象。

侧视图举例说明了视场的位置,其中上部视场312L、312R为上视场在一个方向对齐,下部视场313L和313R为下视场一个方向上对齐。侧视图同时体现了上方视场与下方视场之间约25度的重叠。

图6E示出了与用于示例头戴式显示设备的上、下传感器的重叠视场相关联的另一透视图600。在第一实施例头显610-1中,312R和313R的右侧视场与312L和313L的左侧视场具有从右到左约20度的水平重叠,而312R和312L的上方视场与313R和131L的下方视场具有从上到下约25度的垂直重叠。

在第二实施例头显610-1中,右侧视场312R和313R与左侧视场312L和313L具有自右至左约35度的水平重叠,而上方视场312R和312L与下方视场313R和131L具有自上至下约25度的垂直重叠。

相关专利:Microsoft Patent | Full body tracking using fusion depth sensing

名为“Full body tracking using fusion depth sensing”的微软专利申请最初在2022年6月提交,并在日前由美国专利商标局公布。

需要注意的是,一般来说,美国专利申请接收审查后,自申请日或优先权日起18个月自动公布或根据申请人要求在申请日起18个月内进行公开。注意,专利申请公开不代表专利获批。在专利申请后,美国专利商标局需要进行实际审查,时间可能在1年至3年不等。另外,这只是一份专利申请,不一定意味着相关发明会商业化,而且不确定实际的应用效果。