微软AR专利介绍利用注视点辅助的光标控制方法

利用注视点辅助的光标控制方法

(映维网Nweon 2022年04月29日)随着眼动追踪组件的普及,注视点越发成为AR/VR设备的一个重要交互模式。在名为“Accelerated gaze-supported manual cursor control”的专利申请中,微软就介绍了一种利用注视点辅助的光标控制方法。

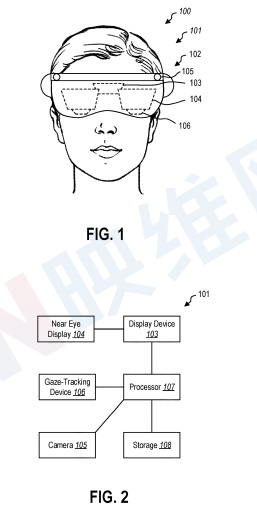

图1包括佩戴头显101的用户100。在一个实施例中,头显101可以包括用于追踪用户注视点的注视点追踪设备106。注视点追踪设备106可以包括一个或多个对用户眼睛成像的摄像头。注视点追踪设备106可以对用户的瞳孔、虹膜、巩膜、用户眼睛的其他部分或其组合进行成像,以计算用户正在注视的方向。

在一个实施例中,注视点追踪设备106可以测量和/或计算用户注视的x和y分量。在其他实施例中,注视点追踪设备106可包括陀螺仪、加速计、多个用于三角定位的传感器,或允许测量头显相对于虚拟环境的方向和/或位置的其他设备。

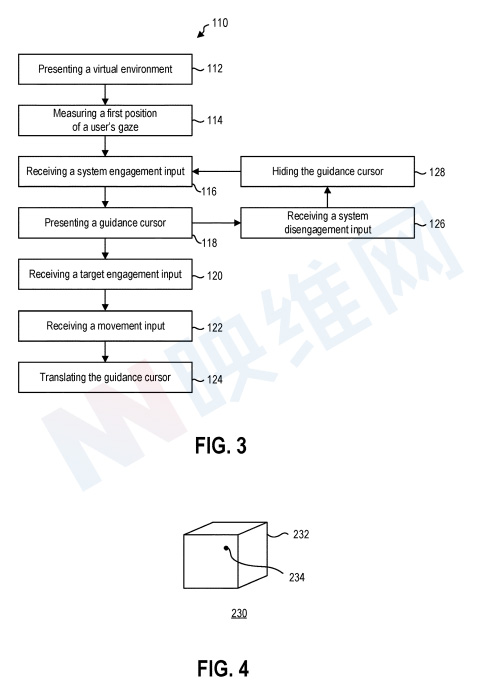

图3是示出与虚拟环境交互的方法110的流程图。112,向用户呈现虚拟环境。114,测量用户注视位置的第一位置。可通过使用注视点追踪设备来测量第一位置,以基于眼动追踪或基于航向追踪来测量用户注视的位置。在这一期间,不向用户呈现标记或光标来指示用户的注视位置的位置。用户注视位置的第一位置由注视追踪设备测量,而不向用户报告第一位置,以最小化对虚拟环境体验的干扰。

116,接收来自输入设备的系统参与输入。在18,在第一位置呈现引导光标。输入设备可以是与头显处理器进行数据通信的手势识别设备,例如摄像头。在其他实施例中,输入设备可以是与头显处理器进行数据通信的语音识别设备,例如麦克风。在又一其他实施例中,输入设备可以是与头显处理器进行数据通信的外设,例如六自由度控制器或其他运动感测控制器。

系统参与输入可以是单手手势,双手手势,语音输入,和/或外设输入。

在接收到系统参与输入后,显示设备显示引导光标。在一个实施例中,引导光标可以具有光标直径。例如,光标直径可以定义用户注视位置的第一个位置周围的区域。

在一个实施例中,由于用户眼睛的小幅运动或颤动,或者由于注视点追踪设备的系统限制,用户的注视位置可能抖动。这时,引导光标直径可以与在一段时间内测量的用户注视位置的注视云有关。在其他实施例中,引导光标直径可以是基于用户在虚拟环境中的视角的固定角宽度。

120,输入设备接收目标参与输入,从而将引导光标与第一位置和用户的注视位置分离。122,从输入设备接收运动输入。124,在接收到移动输入时,基于运动输入相对于第一位置平移引导光标。

可以从与系统参与输入相同的输入设备接收目标参与输入。例如,当识别出用户举手时,可以从手势识别设备接收系统参与输入,当识别出用户用手指向下轻敲时,可以从同一手势识别设备接收目标参与输入。

可以从与目标参与输入和/或系统参与输入相同的输入设备接收运动输入。例如,当识别出用户用手指向下敲击时,可以从手势识别设备接收目标参与输入,当识别出用户在手指保持向下位置时移动其手时,可以从同一手势识别设备接收运动输入。

在一个实施例中,目标参与输入可以是用户手指的向下轻击(例如按下按钮)。目标参与输入可由手势识别设备识别,并可为运动输入设置零点或原点。运动输入可以是用户的手相对于零点的移动。

例如,用户可以向上移动他们的手(例如相对于零点),以在虚拟环境中相对于第一个位置向上移动引导光标。在其他示例中,用户可以将手向后移动,以将引导光标“拉”向用户。然后,用户可以停止目标接合输入,以终止对运动输入的连续测量,并停止移动导航光标。例如,用户可以抬起手指(松开按钮一样)或放松手指和拇指(松开虚拟环境中的抓握物一样)。

在一个实施例中,运动输入可以是语音输入。例如,可以从识别或解释用户语音的语音识别设备接收运动输入。运动输入可以是离散输入。例如,语音识别设备可以检测“向左移动”的百分比语音命令。在其他示例中,语音识别设备可以检测“向右移动两个光标”的距离语音命令,以基于光标直径将光标移动一段距离。在另一些示例中,语音识别设备可以检测并打开诸如“开始向上移动”之类的语音命令,直到语音识别设备检测到诸如“停止”之类的终止语音命令。

继续方法110。126,系统分离输入。系统分离输入可以与系统参与输入相同,以关闭系统参与。例如,系统参与输入可以是鼠标点击一次,系统分离输入可以是鼠标点击第二次。在其他实施例中,系统参与输入可以是离散命令。例如,系统参与输入可以是语音识别系统识别的参与语音命令,系统分离输入可以是语音识别系统识别的分离语音命令。

在接收到系统分离输入时,方法110可以在128隐藏引导光标,以允许用户自由地查看虚拟环境,而不受引导光标的干扰和/或干扰。

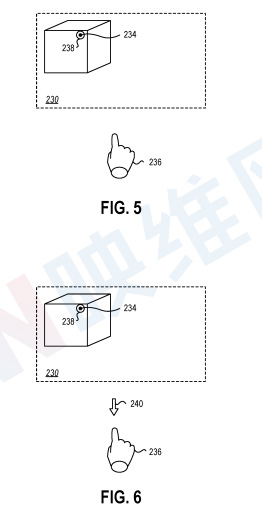

图4到图9示出了关于图3描述的方法的实施例。图4示出了虚拟环境230。虚拟环境230可以包括一个或多个虚拟元素232和/或用户可以与之交互的其他可选对象。注视点追踪设备可检测用户注视位置的第一位置234。如图5所示,在接收到系统参与输入之前,第一位置234可能不会呈现给虚拟环境中的用户。

可以从输入设备236接收系统参与输入。在一个实施例中,可以从手势识别设备接收系统参与输入,手势识别设备在图5中示意性地表示为用户的手。当检测到用户的手向虚拟环境230举起时,可在第一位置234呈现引导光标238。

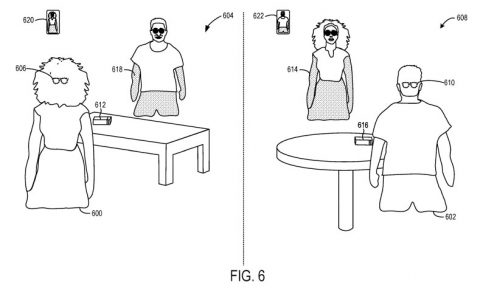

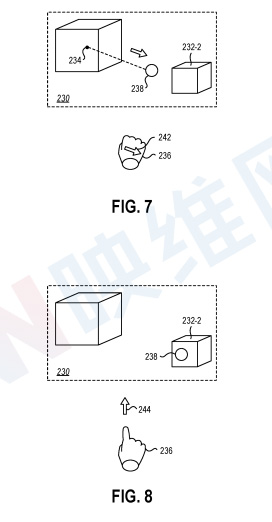

图6示出了来自输入设备236的目标参与输入240的实施例。在接收到目标参与输入240时,引导光标238的位置可以与虚拟环境230内的第一位置234和/或注视点位置分离,如图7所示。引导光标238在虚拟环境230中的位置可以通过输入设备236的运动输入242来细化。引导光标238可以通过虚拟环境转换到例如第二虚拟元素232-2。

在使用输入设备236将引导光标238移动到所需位置时,输入设备236可提供目标分离输入244。在一个实施例中,目标分离输入244可以选择虚拟环境230中的虚拟元素或其他可选对象。例如,注视位置可能不精确且不可靠,所以无法选择虚拟元素。如本文所述,目标参与输入可允许用户将引导光标238与注视位置分离,并使用输入设备236将引导光标移动到期望的可选对象,例如第二虚拟元素232-2,然后通过提供目标分离输入244来选择所述可选对象。

在一个实施例中,在使用输入设备236移动引导光标238期间,可通过将引导光标238定位在可选择对象时改变引导光标238的外观,从而将可选择对象传达给用户。

例如,当在第二虚拟元素232-2移动时,引导光标238可以改变形状,例如从圆形改变为手形光标、十字光标、十字光标、菱形光标或其他形状的改变,以指示第二虚拟元素232-2可以“点击”。在其他示例中,引导光标238可以保持相同的形状和大小变化(例如脉冲越来越大和越来越小),从而指示交互性。

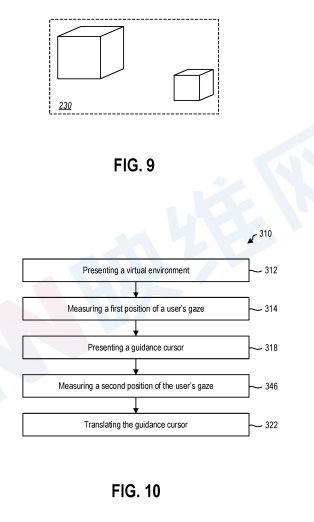

图9示出了用户把手放低或以其他方式提供系统分离输入,以分离输入设备并在虚拟环境230中隐藏引导光标。

如本文所述,输入设备可允许比单独使用注视追踪设备更精确地定位引导光标。然而,使用输入设备而不是注视点追踪设备手动定位引导光标可能会比基于注视点追踪位置的定位更慢地移动引导光标。在一个实施例中,可以在虚拟环境中呈现引导光标,并且当用户的注视位置移动到距离引导光标足够远时,引导光标随后可以通过虚拟环境平滑地转换到用户的注视位置。

相关专利:Microsoft Patent | Accelerated gaze-supported manual cursor control

名为“Accelerated gaze-supported manual cursor control”的微软专利申请最初在2021年12月提交,并在日前由美国专利商标局公布。