微软AR/VR专利分享用于ToF成像的运动校正方法

运动校正

(映维网Nweon 2023年10月19日)诸如飞行时间ToF摄像头这种深度感测系统可用于为HoloLens 2产生环境的深度图像,其中深度图像的每个像素表示到环境中相应点的距离。在ToF成像中,环境中成像表面上点的距离取决于ToF摄像头发出的光传播到该点,然后返回到ToF摄像头传感器的时间间隔长度。

基于相位的ToF成像是ToF成像的一种变体,其中深度是根据从对象反射回来的调幅光的相移来计算。由于ToF摄像头在相位数据采集之间的运动,帧内相位数据可能会相对移位。例如,在第一帧内相位数据采集中,像素可以在场景内的位置以第一调制频率感测相位数据。然后在下一帧内相位数据采集期间,像素可以在第二调制频率下感知不同场景位置的相位数据。不同频率的相位数据变得不一致,则可以称为运动模糊。

所以在名为“Motion correction for time-of-flight depth imaging”的专利申请中,微软提出了一种用于ToF成像的运动校正方法。

为此,将对应于第一照明光调制频率的主动亮度AB图像与对应于第二照明光调制频率的AB图像进行比较,以确定帧内二维平移。帧内二维平移对应于摄像头相对于成像场景的估计运动。

然后,将帧内二维平移应用于相位数据,以帮助相位图像对齐并形成校正后的相位数据。接下来,对校正后的相位数据进行相位解包,得到帧内校正后的三维深度图像。帧内二维平移同时可用于对帧内AB图像执行运动校正。例如,可以通过对校正后的AB图像取平均值来获得帧内校正后的AB图像。

在这样的示例中,将来自第一帧的第一AB图像与来自第二帧的第二AB图像进行比较,以确定帧间二维平移。帧间平移是对帧间运动的估计。然后,可以将帧间二维平移应用于第一帧的深度图像,以形成帧间生成的深度图像。可以根据帧内校正的AB图像确定帧间二维平移。

另外,作为摄像头运动的估计,可以输出帧间二维平移并用于各种时间后处理例程或软件服务。因此,专利描述的实施例可以使用二维帧内AB图像数据帮助实现3D深度数据的运动模糊校正。通过使用二维数据,与使用3D深度数据进行运动模糊校正相比,可以实时执行运动校正,具有相对高效的计算性能。

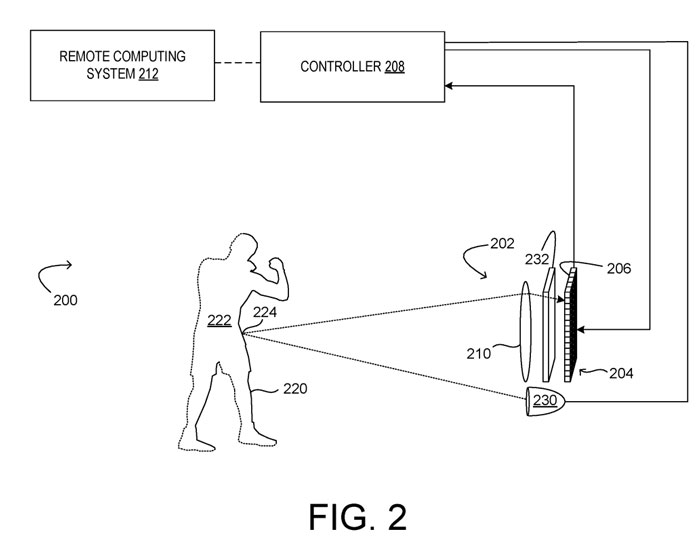

图2显示了包括ToF摄像头202的示例。其中,ToF摄像头是基于相位的ToF深度成像系统200。ToF摄像头202包括传感器阵列204,传感器阵列204包括多个ToF像素206,每个像素206配置为获取捕获相位数据的光样本,控制器208和物镜系统210。

控制器208配置为收集和处理来自传感器阵列204的ToF像素206的数据,从而构建深度图像。控制器208可以包括执行去噪和/或相位展开的可执行指令。

深度成像系统200同时包括调制光发射器230和用于传感器阵列204的模拟和/或数字调制电子快门232,以通过传感器阵列204控制光的集成。调制光发射器230可以配置成发射具有可由ToF像素206检测到的任何频率的电磁辐射。

调制光可以按顺序或同时以不同频率调制,而传感器阵列204配置为采样从调制光发射器230反射到表面220并返回到摄像头的光。传感器阵列204的每个ToF感测像素206可包括一个或多个像素tap,以在不同的时间间隔集成反射光信号,并由此确定相移。

对于每个调制频率,控制传感器阵列204以来自光源的幅调制光的多个相位角对光进行采样,并从用于调制频率的多个光样本中确定用于每个调制频率的相位样本。然后相位样本可以展开以获得每个像素的深度值。

由于调制光的周期性,测量的总相位每2π重复一次。由于n(k)不能通过基于相位的ToF像素直接测量,因此总相位以及与测量相关的实际距离是模糊的。因此在基于相位的ToF成像中,可以测量的距离(无模糊范围)受到调制频率的限制。

可以使用两个或多个不同的调制频率来增加无模糊范围,然后将收集到的相移数据展开,以准确确定距离。

图3示意性地说明用于多个K个调制频率的示例ToF图像数据300。数据300表示深度成像系统200在多频帧采集过程中可以获取的数据。

在所示的示例中,深度数据包括针对K个调制频率中的每个频率的M×N数据数组,从而产生帧内深度数据302a-c的M×N网格,其中每个网格中的每个像素304表示在K个调制频率的相应照明光调制频率K下获得的测量值。

测量的相位用于计算与像素相关联的深度值。但如上所述,在基于相位的ToF成像中,可以测量的距离(无模糊范围)受到调制频率的限制。因此,可以使用一组K≥2个调制频率K来增加范围,从而允许相位信息解开以准确确定距离。

相位展开是通过用多个不同频率的调幅光照射场景来消除相移数据歧义并识别正确距离值的一种方法,因为对于每个照明光的频率,距离歧义是不同的。

但如上所述,如果ToF深度摄像头处于运动状态,则可能发生相位展开错误。由于每个频率的深度数据采集是顺序进行,因此相位图像和AB图像在一帧内暂时分离。

例如,帧内相位图像306a可包括朝着帧的开始处获取的第一频率ƒ1相位数据,帧内相位图像306b可包括在帧的中间处获取的第二频率ƒ2相位数据,帧内相位图像306b可包括朝着帧的结束处获取的第三频率ƒ3相位数据。

因此,如果ToF深度摄像头在帧内采集之间移动,三种不同频率的相位数据可能会移位和错位。相位数据不一致可能导致相位展开时出现错误。

所以,微软提出了利用AB图像数据来估计运动并确定二维平移的解决方案。

这家公司指出,尽管可以使用深度数据,但由于场景中对象之间的主动亮度差异,基于AB图像数据确定二维平移可能更加稳健。然后,可以使用二维平移对相位数据执行帧内运动校正。对帧内校正的相位数据执行相位展开可以帮助避免由于运动模糊而导致的展开错误。

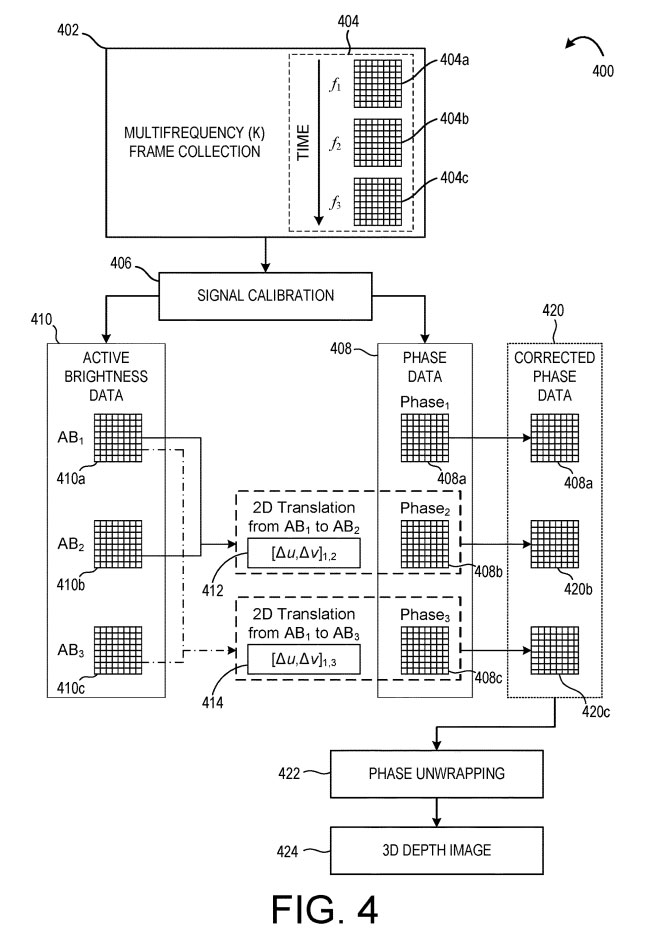

图4示出用于在相位展开之前对深度数据执行这种校正的示例方法。方法400可在接收来自ToF深度摄像头的数据的计算系统实现。

在402,进行多频帧收集,其中通过ToF图像传感器收集多个帧内相位样本。对多个照明光调制频率(ƒ1、ƒ2、ƒ3)中的每一个采集帧内相位样本,以形成相应的帧内深度数据404a-c。在本例中,首先获取帧内深度数据404a,其次获取帧内深度数据404b,第三获取帧内深度数据404c,如时间箭头所示。

在406,进行信号校准校正以获得相位数据408和主动亮度数据410。如上所述,由于摄像头运动,不同频率的帧内深度数据可能会相对移位。因此,方法400比较主动亮度数据410来估计和校正运动。

这里,将帧内AB图像410a与帧内AB图像410b进行比较,以确定第一帧内二维平移412。从AB1到AB2的二维平移可以用[Δu, Δv]1,2来表示,其中Δu是x方向的像素位移,Δv是y方向的像素位移。帧内二维平移412是帧内深度数据404a和帧内深度数据404b之间运动的估计。

接下来,将帧内AB图像410a与帧内AB图像410c进行比较,以确定第二个帧内二维平移414,表示为[Δu, Δv]13。

在一个实施例中,可以将帧内AB图像410b与帧内AB图像410c进行比较,以确定第三帧内二维平移。在其他示例中,可以比较任何合适的帧内AB图像对以确定相应的帧内二维平移。任何合适的方法都可以用来比较AB图像并确定平移。在一个示例中,从AB图像中提取特征,形成特征映射,并用于比较图像。

在确定二维平移后,可以使用确定的平移来校正相位数据。在图4所示的实施例中,对相位图像408b施加帧内二维平移412,对相位图像进行校正,形成校正后的相位图像420b。同样,对相位图像408c进行帧内二维平移414,对相位图像进行校正,形成校正后的相位图像420c。

因此,校正后的相位数据420表示已“重新对齐”到相位图像408a的相位数据。在一个示例中,可以应用一个或多个二维平移来形成与相位图像408b或408c对齐的校正相位图像。

在422,方法400同时包括对校正后的相位数据420执行相位展开以形成深度图像424。由于校正后的相位图像420b、420c可以与相位图像408a重新对齐,与忽略运动模糊校正的示例相比,在422的相位展开可以产生相对较少的展开误差。

所以,方法400可以帮助在处理深度数据404以形成深度图像424方面实现更好的性能。

另外,帧内二维平移的应用可以通过卷积执行,因此可以与也利用卷积的空间和时间滤波处理相结合。同时,作为摄像头运动的估计,确定的帧内二维平移可能有助于实现各种后处理应用,例如时间滤波器、轨迹估计、动态区域估计或映射。类似的技术可用于校正帧内AB图像并形成帧内校正的AB图像。

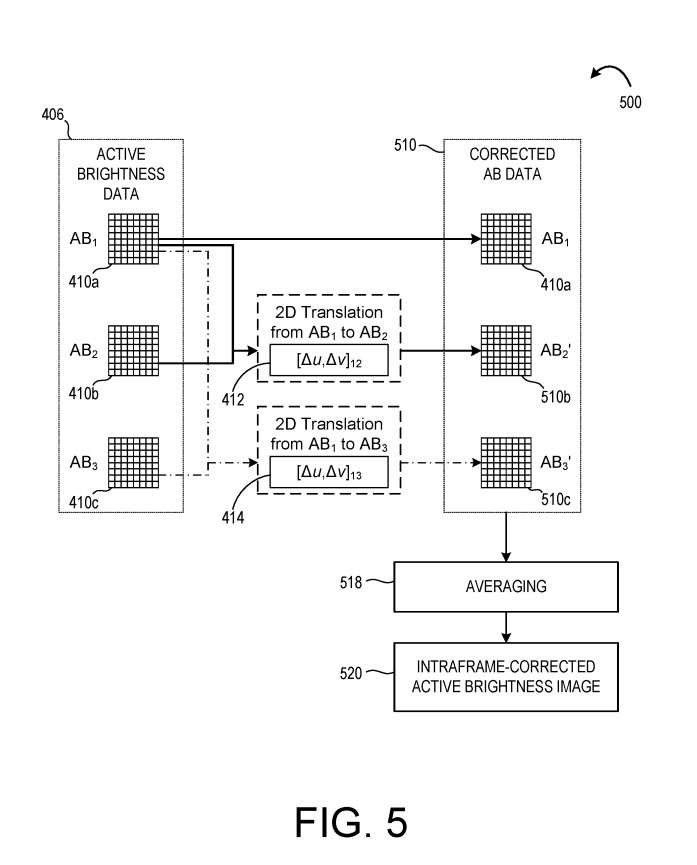

参照图5,方法500利用帧内二维平移412、414形成校正后的AB数据510。在一个示例中,方法500与方法400一起执行。在其他示例中,方法500与方法400分开执行。

如图5所示,将帧内二维平移412应用于帧内AB图像410b,对图像进行校正,形成校正后的AB图像510b。进一步,将帧内二维平移414应用于AB图像410c,以形成校正后的AB图像510c。与帧内AB图像408a一起,校正后的AB图像510b-c形成校正后的AB数据510。

在518,方法500进一步包括对校正后的AB数据510进行平均,以形成帧内校正后的AB图像520。可输出帧内校正的AB图像520以作进一步处理和/或输出到显示器。

帧内校正的AB图像也可用于生成帧间深度图像。除了校正深度图像帧内的运动模糊外,同时可以在帧之间进行校正。

相关专利:Microsoft Patent | Motion correction for time-of-flight depth imaging

名为“Motion correction for time-of-flight depth imaging”的微软专利申请最初在2022年3月提交,并在日前由美国专利商标局公布。