微软AR/VR专利提出“独眼”传感器,将双目视觉变为单眼视觉,统一感知

具有一种以上传感模式的单个物理传感器

(映维网Nweon 2024年08月26日)分布式传感器之间的不可靠校准会导致各种各样的问题。其中一个来源包括AR/VR设备中实现的框架的不完全刚度。随着时间的推移,AR/VR设备的框架在工业、家庭和工作环境中使用时所承受的扭曲可能导致传感器之间的物理位移。

对于分布式传感器,信号的分布和多信号/多模态处理是一个复杂的问题。例如,在包含可见光传感器和深度传感器的设备中,头部追踪计算通常使用来自可见光摄像头的数据,而不会利用来自深度传感器的数据。另外,类似的计算由不同的传感器执行多次,而这种冗余和低效率使得设备更难以满足尺寸、重量和功率限制。

鉴于上述观察,微软在一份专利申请中提供了一个“独眼”传感器的概念。

“独眼”是指一个逻辑概念,它将经典的双目视觉转变为单眼视觉,用独眼取代两只眼睛,从而解释对世界与物理方面的统一感知。对于头戴式显示器,这可以通过单个独眼传感器系统实现。其中,系统可以感知每个像素的深度和光强度。然后,基于独眼传感器系统,可以在软件中合成和渲染左右双目图像。

独眼传感器系统可以以多种方式实现。头戴式显示器可以设计具有多模态独眼传感器系统,系统包括能够提供多模态数据信号的一个或多个传感器。在一个实施例中,多模态独眼传感器系统包括至少两种彼此靠近的不同类型的传感器。多模态独眼传感器系统可用于合成双眼视图,以显示给用户的双眼。

微软指出,独眼传感器系统可以克服分布式传感器在头戴式显示器中存在的诸多缺点,包括不准确的校准、复杂的计算和低效的计算冗余。独眼设计简化了头戴式显示器的硬件结构,扩展了头戴式显示器的应用范围,并实现了高精度、大工作量和灵活的SWaP利用。

例如,当前的AR/VR设备倾向于依赖无源视觉传感器而不是ToF传感器来降低设备的SWaP利用率。然而,这样的实现在低光环境下可能导致不可靠和不准确的性能。通过实现单个独眼传感器系统而不是多个分布式传感器,SWaP约束更容易实现。

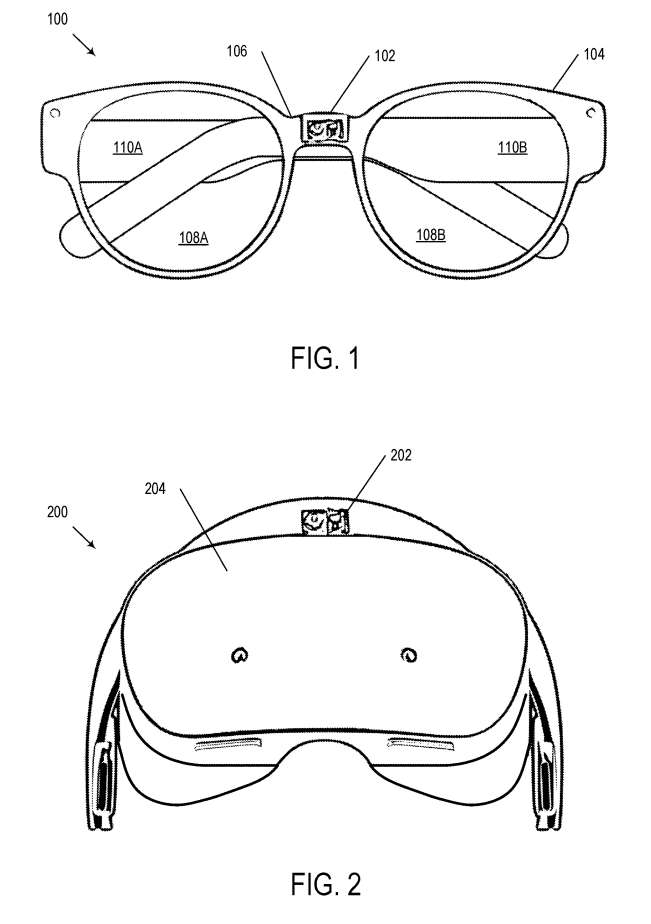

图1示出了实现独眼传感器系统的示例头戴式显示器100。

头戴式显示器100包括独眼传感器系统102。所述独眼传感器系统102包括具有不同传感模式的一个或多个传感器,称为多模态传感器。

多模态传感器可以实现为能够具有一种以上传感模式的单个物理传感器。多模态传感器可以实现为两个或多个传感器,每个传感器能够具有不同的传感模式。

在一个实施例中,独眼传感器系统102包括深度传感器(例如ToF传感器)和可见传感器(例如在红、绿、蓝(RGB)波长下工作的摄像头)。所述独眼传感器系统102可根据所述应用包括附加传感器。传感器示例包括加速度计、陀螺仪、磁力计和惯性测量单元(imu)。

多模态传感器可以实现为能够感知多模态数据的单个物理传感器。例如,深度传感器和可见光传感器在物理上可以是具有共同焦平面的单个传感器,在所述焦平面上,通过滤波和处理,深度传感器通常使用的可见光光谱和红外光谱都可以感测。

多模态传感器同时可以实现为多个物理上独立的传感器。例如,独眼传感器系统102可以包括在传感器包中实现的两个物理上不同的传感器,其中两个传感器布置在彼此靠近的位置。

头戴式显示器100还可以包括一个控制器。控制器除其他组件外,可包括逻辑子系统和存储子系统,该存储子系统存储逻辑子系统可执行的指令,以控制头戴式显示器100的各种功能,包括但不限于对独眼传感器系统102及其多模态传感器的控制。

所述独眼传感器系统102中的多模态传感器可以以各种方式布置和实现。例如,多模态传感器可以集成在一个紧凑的封装中。

在一个实施例中,至少两个多模态传感器是共存的。同一位置的传感器可以以各种方式布置。共定位传感器可以作为具有多种传感模式功能的单个设备实现,或可以作为单个传感器封装中彼此接近的独立设备实现。

例如,可以实现ToF传感器和RGB传感器来创建一个具有可见和深度功能的共定位传感模块。在一个实施例中,位于同一位置的传感器的中心彼此之间的距离在两厘米以内。在进一步的实现中,位于同一位置的传感器的中心彼此之间的距离在一厘米以内。

另外,共定位的传感器可以共享一个公共焦点和一个焦平面。例如,可以在单个物理设备实现共定位传感器,所述设备可以使用各种滤波和处理技术感应可见光光谱(用于图像数据)和红外光谱(用于深度数据)。同一位置的传感器可以聚合,使它们共享相同或基本上相同的视场。需要注意的是,“基本相同”表示足够接近,可以从位于同一位置的传感器感知的数据合成左右视图。

图2示出实施独眼传感器系统的示例头显200。

安装在头戴式显示器的独眼传感器系统可以为AR/VR应用提供各种功能。实现多模态传感器或彼此接近的多个传感器可以减轻使用分布式传感器的头戴式显示器的几个缺点。

与具有分布式传感器的设备相比,基于独眼传感器的头戴式显示器的优点包括校准参数更简单,并且能够通过利用跨多模态传感器的互补数据信号减少了计算冗余。例如,可以使用来自独眼传感器系统的多模态数据执行各种应用程序的运行时计算。

在一个实施例中,将来自独眼传感器系统的多模态数据传输到执行运行时计算的远程设备。另外,可以实施独眼传感器系统以提供双目显示渲染。以前,这是使用至少两个分布式RGB摄像头执行。限制,独眼传感器系统可以使用可见光传感器和深度传感器执行这样的渲染。传感器的数据可以合成不同角度的图像,从而实现双眼显示渲染。

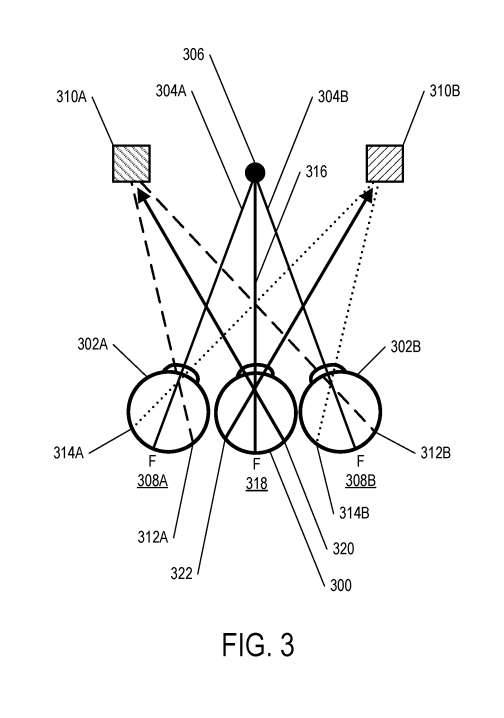

独眼概念源自生物学,即可以感知从用户眼睛中获得的方向,就好像你是从观察者的眼睛之间的一个有利位置查看场景一样。尽管人的解剖眼睛是双眼视觉,但大脑看到的是单一图像。

图3示出了独眼300的概念构想。如图所示,独眼300位于左眼302A和右眼302B之间。两个眼睛302A,304B的主要视觉方向由线304A,304B表示。

来自第一对象310A和第二对象310B的光刺激左眼和右眼302A、302B中的不同视网膜点。一个人眼睛中的每个视网膜点在另一只眼睛中都有一个相应的视网膜点,这对视网膜点称为“对应点”。

来自对象的光可以刺激每只眼睛的视网膜点。信息传送到大脑,在相同的空间方向形成一个单一的视觉图像。然而,如果不同的视网膜点受到刺激,就会出现复视。

在说明性概念中,第一对象310A刺激左眼视网膜点312A和右眼视网膜点312B。这两个视网膜点312A和312B是对应点。同样,第二对象310B刺激左眼视网膜点314A和右眼视网膜点314B。这两个视网膜点314A和314B是对应点。

以上观察结果使得独眼300能够获得与两只眼睛302A、304B相似的信息。在独眼300的主要视觉方向上的线316将注视点306与独眼300的中央凹318连接起来。对应点312A、312B原为视网膜点320,对应点312A、312B还原为视网膜点322。由此可以确定两个对象310A、310B的空间位置。

独眼概念可适用于头戴式显示器的设计,以实现为多模态独眼传感器系统。在一个实施例中,多模态独眼传感器系统用于合成各种应用的双目信息,例如AR/VR应用中的双目渲染。另外,多模态独眼传感器系统的实现可以简化计算机视觉运行时间并使其具有鲁棒性。

对于VR应用,透视模式通常实现两个RGB摄像头来捕获当前场景,然后可以通过显示器呈现给用户查看。低延迟渲染可以通过对原始RGB摄像头信号的轻量级处理来执行,从用户眼睛的有利位置渲染场景,以提供双目浏览体验。

这两个摄像头通常分别靠近用户的眼睛,以尽量减少通过渲染的视差影响。瞳孔间距可用于物理调整两个显示器,这样用户的眼睛和大脑就可以融合双眼刺激,从而产生对3D场景的连贯感知。

独眼传感器系统无需使用两个物理高分辨率RGB摄像头即可实现透视渲染。

在一个实施例中,独眼传感器系统包括一个可见传感器和一个深度传感器。可见传感器的例子包括各种无源可见摄像头。可见传感器可以是一个高分辨率RGB摄像头。作为独眼传感器系统的一部分,高分辨率RGB摄像头和深度传感器可以共存。示例深度传感器包括ToF传感器,包括间接飞行时间摄像头和直接飞行时间摄像头。

高分辨率RGB摄像头与ToF传感器共存。在进一步的实施例中,传感器是聚合的。观察到的共定位RGB信息和深度信息可用于在软件和/或硬件中渲染两个显示器的左眼和右眼图像,就好像两只眼睛直接查看物理场景一样。

当可见传感器和深度传感器同时放置时,每个像素的深度和每个像素的RGB值可以对齐。根据已知的基线参数,可以执行左右视图的渲染。

例如,可以根据深度数据的信息,将图像数据中的像素点映射到不同的点,以合成左右视图对应的图像。

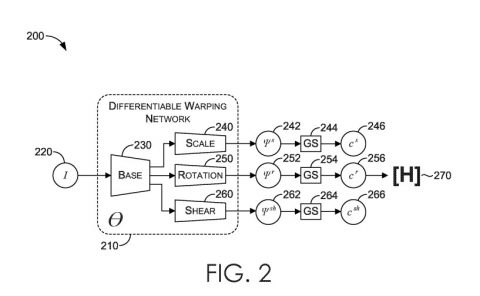

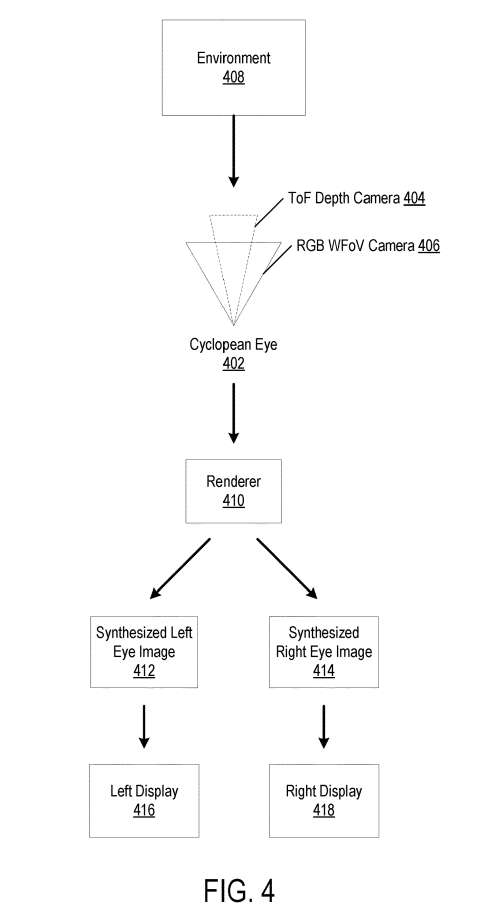

图4示出使用由独眼传感器系统402获得的共定位RGB和深度图像的示例双目渲染过程400。所述独眼传感器系统402可以以各种方式实现。

在所描述的示例中,独眼传感器系统402包括ToF深度摄像头404和RGB宽视场摄像头406。ToF深度摄像头404和RGB宽视场摄像头406可以在预定的距离内共存。

当用户移动他或她的头和眼睛时,深度摄像头和RGB摄像头覆盖的中央区域可以以相对较高的目标分辨率渲染祖师殿场景。外围区域没有利用高质量的深度估计,所以可以在外围显示区域以相对较低的目标分辨率呈现。这种自适应分辨率渲染模型同样模仿了人眼

来自待渲染环境408的深度和RGB图像数据分别由ToF深度摄像头404和RGB宽视场摄像头406记录。深度和图像数据可以传递到合成左412和右414图像的渲染器410。渲染器410可以作为软件、硬件或两者的组合来实现。

合成左412和右414图像以分别再现用户左眼和右眼的视图。因此,左412和右414图像和图像数据都可以具有相同环境场景的不同角度视图。可以应用不同的方法来合成或渲染图像。在一个实施例中,深度和图像数据与基线参数一起使用一类向后和向前翘曲技术来合成左412和右414图像。

合成左412和右414图像后,可以将图像呈现给用户显示。可以分别使用头显的左显示器416和右显示器418显示左412和右414图像。

除了渲染左412和右414图像外,来自独眼传感器系统的多模态数据同时可用于执行各种应用的运行时计算,包括头部追踪、手部追踪、眼动追踪、场景/环境理解和对象理解。

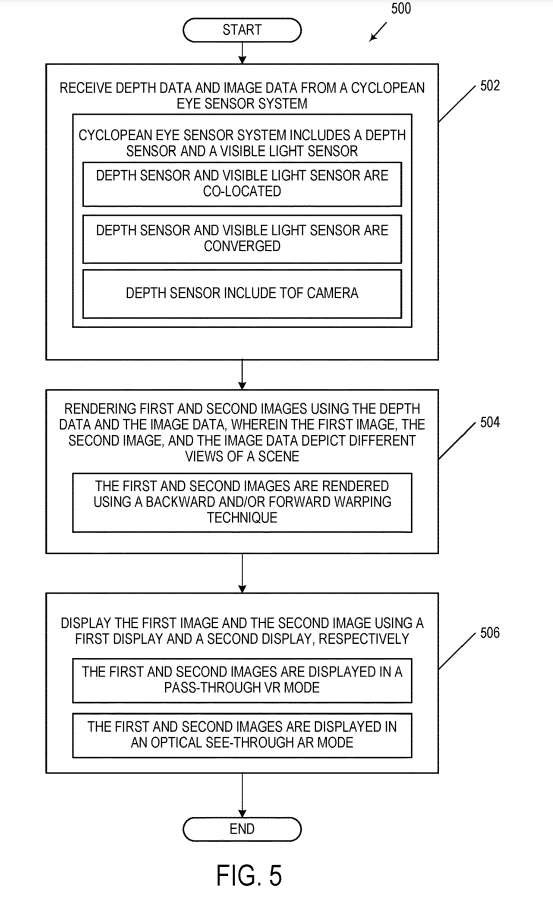

图5示出使用独眼传感器系统绘制双目视图的示例方法流程图。

在步骤502中,从独眼传感器系统接收深度数据和图像数据。独眼传感器系统可以以多种方式实现。

所述独眼传感器系统可包括一个或多个传感器以实现多模态传感器系统。传感器可以以各种方式布置和实现。例如,传感器可以集成在一个紧凑的封装中。多模态传感器系统实现为能够具有一种以上传感模式的单个物理传感器。例如,可以使用可以感知多模态数据的单个物理传感器。多模态传感器系统 同时可以实现为两个或多个传感器,每个传感器能够具有不同的传感模式。多模态传感器系统的传感器可以同时放置。

在步骤504中,使用深度数据和图像数据呈现第一和第二图像。图像可以使用许多不同的技术中的任何一种以各种方式呈现。可以渲染第一和第二图像,以分别再现用户左眼和右眼的视图。所以,第一和第二图像和图像数据都可以具有相同环境场景的不同角度视图。在一个实施例中中,利用向后和向前翘曲技术来使用图像数据和深度数据渲染图像。

在步骤506中,使用第一显示器显示第一图像。使用第二显示器显示第二图像。

微软总结道,使用独眼传感器系统为AR/VR应用合成增强的左右视图有多个优点。例如,独眼传感器系统的实现可以包括不需要计算左右显示器和摄像头之间的视差校正。在实现分布式传感器的头戴式显示器中,一般通过使用两个摄像头分别捕获用户眼睛所看到的场景来实现VR。在这种情况下,需要对显示器和相关摄像头之间的视差进行校正。

但对于独眼传感器系统,可以使用已知的IPD和基线值对单个测量深度和RGB源正确合成左视图和右视图。

另一个优点包括简化校准。由于多模态传感器是在独眼传感器系统中实现,所以不存在对准和校准的问题。

实现AR/VR应用的独眼传感器系统可以帮助促进各种计算机视觉运行。与分布式传感设备相比,运行时可以简化,并提供更强的鲁棒性和可靠性。例如,头显中经常出现的一个问题是头部追踪应用中的分布式摄像头之间的度量校准不可靠。

一个独眼传感器系统可以由多个多模态传感器共同定位来实现。所以,传感器之间的校准很少变化。在封装中实现的具有汇聚视场的传感器可以进一步缓解校准和非刚性问题。

在一个实施例中,独眼传感器系统包括单个深度传感器和单个可见光传感器。在这种情况下,立体深度不需要计算校准、特征提取和三角测量带来的相关误差,因为深度可以直接从深度传感器获得。这可以显著减少对设备计算的需求,因为特征匹配和立体三角测量是头部追踪的重要组成。

映射既可以在设备之内完成,又可以在设备之外完成。映射同时可以使用从深度传感器得到的可靠的3D估计。由于测量的误差不随深度变化很大,所以高斯误差模型可以更准确地进行融合和全局3D优化。这可以在最小化计算的同时创建可靠的大比例尺映射。

与分布式传感器设备相比,实现单眼传感器系统的头显可以高效可靠地生成具有对象和表面标签和功能的语义3D世界地图,同时保持具有可管理SWaP的紧凑传感器包。独眼传感器系统有助于场景和对象的理解。通

过深度传感器进行直接深度测量,并通过头部追踪进行校准和融合,可以创建自适应分辨率的3D点云和网格。额外的感知通过与深度对齐的RGB摄像头提供,语义标签可以通过深度网络派生。

如上所述,与利用分布式传感器进行显示渲染和用于创建和管理AR/VR体验的计算机视觉运行时的设备相比,独眼传感器系统具有SWaP优势。一个独眼传感器系统可以作为一个紧凑的传感器包来实现,它有利于通信和计算的局部信号分配。

头显的硬件实现同样更简单。例如,显示器可以很容易地适应任何IPD和其他类型的眼睛方面,因为提供的图像是使用独眼输入完全合成。有了这样的系统,头戴式显示器可以实现透视模式,而无需为每只眼睛使用高分辨率摄像头,从而实现低SWaP设计的设备。

在单个封装中放置多模态传感器减少或消除了通常存在于分布式传感器之间的变量校准问题。这使得高质量的校准和深度与视觉特征的直接关联成为可能。立体重建不再是必要的。因此,计算机视觉运行时间得到了改进,即便在无纹理表面和低光室内环境中都能实现可重复和可靠的体验。

相关专利:Microsoft Patent | Head-mounted displays comprising a cyclopean-eye sensor system

名为“Head-mounted displays comprising a cyclopean-eye sensor system”的微软专利申请最初在2023年2月提交,并在日前由美国专利商标局公布。